Starke Passwörter, Zwei-Faktor-Authentifizierung und Fingerabdruckscanner sind alles Möglichkeiten, um Benutzerdaten zu schützen. In den letzten Jahren haben Smartphone-Hersteller begonnen, einen neuen Trend aktiv zu fördern - automatische Gesichtserkennungssysteme für Menschen. Mal sehen, woher sie kommen, wie sie arbeiten und warum sie gebraucht werden.

Ein bisschen Geschichte

Die ersten geschlossenen Experimente zur Computererkennung menschlicher Gesichter begannen in den 1960er Jahren. Die Hauptprobleme der Wissenschaftler - die Unfähigkeit von Computern, unterschiedliche Ausdrücke und altersbedingte Veränderungen im Gesicht einer Person zu erfassen, sowie die geringe Automatisierung des Prozesses. Die Forschung erreichte Ende des 20. Jahrhunderts ein neues Niveau - dann begannen Computer bei der Analyse von Fotografien zu lehren, Menschen aus verschiedenen Blickwinkeln zu "erkennen" und nicht auf Bärte, Schnurrbärte, Kosmetika und andere "Störungen" zu reagieren. Dieser Prozess dauert bis heute an - es gibt kein System auf der Welt, das in 100% der Fälle funktioniert und eine hohe Erkennungsgenauigkeit bietet. Zu Beginn des 21. Jahrhunderts hat sich die Technologie jedoch weiterentwickelt, und es wurde eine neue Methode zur Gesichtserkennung auf der Grundlage des 3D-Scannens eingeführt. Wir werden uns heute darauf konzentrieren.

Funktionsweise von Gesichtserkennungssystemen auf Smartphones

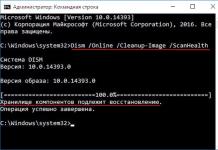

Die Gesichtserkennung bei modernen Geräten kann wie bei jedem anderen Prozess der biometrischen Benutzeridentifizierung grob in vier Stufen unterteilt werden:

- Erster Gesichts-Scan. Mit einem speziellen Sensor oder einer speziellen Kamera führt das System einen dreidimensionalen Gesichts-Scan durch und verarbeitet die empfangenen Informationen.

- Extrahieren eindeutiger Daten und Erstellen einer darauf basierenden Vorlage. In diesem Stadium bestimmt das System eine Reihe von Merkmalen eines bestimmten Gesichts: die Konturen der Augenhöhle, die Breite der Nase und die Form der Wangenknochen.

- Abgleichen der fertigen Vorlage mit neuen Eingaben, z. B. dem Gesicht einer anderen Person.

- Suche nach Übereinstimmungen. Das System entscheidet, ob der Funktionsumfang des neuen Beispiels mit der vorgefertigten Vorlage übereinstimmt, und führt eine bestimmte Aktion aus. In unserem Fall wird der Bildschirm entsperrt oder gesperrt.

Nachteile

Auf modernen Smartphones dauert das Scannen weniger als eine Sekunde. Der 3D-Sensor kann jedoch andere Methoden zur Benutzeridentifizierung, wie z. B. einen Fingerabdruckscanner, noch nicht vollständig ersetzen. Es gibt verschiedene Gründe:

- das System ist bei schlechten Lichtverhältnissen instabil.

- sie kommt mit verschiedenen Gesichtsausdrücken, Frisuren, Gesichtshaaren und anderen Störungen nicht gut zurecht.

- das System vergleicht die Vorlage nicht immer genau mit den neuen Eingabedaten, weshalb das Gerät mithilfe des Fotos des Besitzers entsperrt werden kann.

Wo werden Gesichtserkennungssysteme eingesetzt?

Bisher wurden Gesichtserkennungs- und Identifikationssysteme ausschließlich von Strafverfolgungsbehörden, auf Flughäfen und beim Zoll eingesetzt. In den letzten Jahren hat sich der Schwerpunkt auf PCs, Smartphones und Wearables verlagert, bei denen Gesichtsscanner ein zusätzliches Werkzeug für die Benutzerauthentifizierung darstellen. Beispielsweise ist das im März vorgestellte Galaxy S8 mit einem 3D-Sensor ausgestattet, mit dem das Gerät entsperrt werden kann. Es ist bemerkenswert, dass Benutzer eine zuverlässigere Methode zur biometrischen Überprüfung verwenden müssen, um Zahlungen zu tätigen oder mit vertraulichen Ordnern zu arbeiten - einen Fingerabdruck.

Ein weiterer Anwendungsbereich der Gesichtserkennungstechnologie ist die Identifizierung von Personen auf Fotografien. Diese Funktion funktioniert in Google Fotos-Alben und in der Fotos-App auf iPhone und Mac. In letzterem Fall erkennt das System die Personen in den Bildern, die der Benutzer in die Bibliothek hochlädt, und lässt Sie dann Namen und Kontaktdaten hinzufügen, um das Auffinden der Bilder zu erleichtern.

Wenn Apple Siri fertiggestellt hat, können wir die benötigten Fotos öffnen, ohne das Gerät zu berühren, und sie in sozialen Netzwerken teilen, alte Freunde anrufen, die wir in einem Album mit Universitätsfotos gesehen haben, oder einen Assistenten bitten, uns zu zeigen, wie sich unser Erscheinungsbild in den letzten 5 Jahren verändert hat. Und genau das fällt mir zuerst ein.

Sie gehen die Treppe hinauf und betreten den Aufzug. Er weiß, in welche Etage Sie gehen müssen. Die Türen zur Wohnung öffnen sich vor Ihnen. Der Computer und das Telefon "erkennen" Sie und benötigen kein Passwort.

Auf den ersten Blick scheint es, dass jede Organisation, die sich dies leisten kann, jeden Schritt beobachtet und ein Dossier über Sie sammelt. Aber Sie können sich nicht einmal vorstellen, wie weit sich Gesichtserkennungstechnologien auf der ganzen Welt verbreitet haben und welche starken Aussichten sie versprechen. Zusätzlich zu den obigen Beispielen können Sie mit Gesichtserkennungssystemen solche einfachen und komplexen Dinge tun:

- bestätigung der Studentenidentität während der Online-Prüfungen;

- identifizierung von Personen von der "schwarzen Liste" am Eingang zu Stadien und Nachtclubs;

- bezahlung von Waren;

- halten Sie Ihren Platz in der Schlange, wenn Sie einen Vergnügungspark besuchen.

- entsperren Ihres Telefons oder Computers.

Was kann ich sagen, wenn es allein in Moskau bereits ein Netzwerk von mehr als 150.000 Videoüberwachungskameras im Freien gibt? Es gibt keinen Ort, an dem man sich vor ihnen verstecken kann, und das bringt die Leute zum Nachdenken, aber das Ausmaß der "Überwachung" ist nicht so groß. Das Netzwerk verwendet ein leistungsstarkes Gesichtserkennungssystem, benötigt jedoch viel Energie für den Betrieb, sodass nur 2-4.000 Kameras in Echtzeit arbeiten. Bisher ist die Massenüberwachung der Bevölkerung nur erschreckend, daher lohnt es sich, sich auf die wirklichen Vorteile dieser Technologie zu konzentrieren. Aber das Wichtigste zuerst.

Wie funktioniert das Gesichtserkennungssystem?

Haben Sie sich jemals gefragt, wie Sie selbst ein Gesicht erkennen, erkennen? Wie macht ein Computer das? Natürlich haben menschliche Gesichter bestimmte Eigenschaften, die leicht zu beschreiben sind. Der Abstand zwischen den Augen, die Position und Breite der Nase, die Form der Stirnkämme und des Kinns - all diese Details bemerken Sie unbewusst, wenn Sie eine andere Person ansehen. Der Computer tut dies alles mit einer gewissen Effizienz und Genauigkeit, da er durch die Kombination all dieser Metriken die mathematische Formel eines menschlichen Gesichts erhält.

Wie gut funktioniert das Gesichtserkennungssystem derzeit? Nicht schlecht, aber manchmal falsch. Wenn Sie jemals auf Facebook oder einer anderen Plattform auf Gesichtserkennungssoftware gestoßen sind, haben Sie wahrscheinlich bemerkt, dass es genauso viele unterhaltsame wie genaue Ergebnisse gibt. Obwohl die Technologie nicht zu 100 Prozent genau ist, ist sie gut genug, um weit verbreitet zu sein. Und dich sogar nervös machen.

Paul Howie von NEC sagt, dass ihr Gesichtserkennungssystem Gesichter nach individuellen Identifikatoren durchsucht:

„Zum Beispiel betrachten viele den Abstand zwischen den Augen als ein einzigartiges Merkmal. Oder es könnte der Abstand vom Kinn zur Stirn und zu anderen Komponenten sein. Insbesondere berücksichtigen wir 15 bis 20 Faktoren, die als wichtig angesehen werden, sowie andere Faktoren, die nicht mehr so \u200b\u200bwichtig sind. Dadurch wird ein dreidimensionales Bild des Kopfes der Person erstellt. Selbst wenn dieser teilweise bedeckt ist, können wir dennoch eine genaue Übereinstimmung erzielen. Das System nimmt dann die Gesichtssignatur und leitet sie durch die Datenbank. "

Sollte ich mir Sorgen um Gesichtserkennungssoftware machen?

Gesichtserkennung sind in erster Linie Daten. Daten können oft ohne Erlaubnis gesammelt und gespeichert werden. Sobald die Informationen gesammelt und gespeichert sind, können sie gehackt werden. Gesichtserkennungsplattformen wurden noch nicht stark gehackt, aber mit der Verbreitung der Technologie sind Ihre biometrischen Daten in den Händen von immer mehr Menschen.

Es gibt auch Eigentumsfragen. Die meisten Menschen wissen nicht, dass ihre Daten ab diesem Zeitpunkt Facebook selbst gehören, wenn sie sich bei Social-Media-Plattformen wie Facebook anmelden. Da die Anzahl der Unternehmen, die Gesichtserkennung verwenden, ständig wächst, müssen Sie sehr bald nicht einmal Ihre eigenen Fotos ins Internet hochladen, um Kompromisse einzugehen. Sie sind dort bereits gelagert und schon lange gelagert.

Apropos Software, alle arbeiten auf unterschiedliche Weise, verwenden jedoch grundsätzlich ähnliche Techniken und neuronale Netze. Jedes Gesicht hat viele Besonderheiten (es ist unmöglich, zwei identische Gesichter auf der Welt zu finden, und es gab so viele davon in der gesamten Geschichte der Menschheit!). Beispielsweise definiert die FaceIt-Software diese Funktionen als Ankerpunkte. Jedes Gesicht enthält ungefähr 80 Knotenpunkte, ähnlich den zuvor erwähnten: den Abstand zwischen den Augen, die Breite der Nase, die Tiefe der Augenhöhlen, die Form des Kinns, die Länge des Kiefers. Diese Punkte werden gemessen und erzeugen einen numerischen Code - einen "Gesichtsdruck" - der dann in die Datenbank eingespeist wird.

In der Vergangenheit stützte sich die Gesichtserkennung auf 2D-Bilder, um andere 2D-Bilder aus der Datenbank zu vergleichen oder zu identifizieren. Für Effizienz und Genauigkeit musste das Bild ein Gesicht sein, das direkt in die Kamera blickte, mit geringer Lichtstreuung und ohne Gesichtsausdruck. Natürlich hat es verdammt schlecht funktioniert.

In den meisten Fällen wurden die Schnappschüsse nicht in einer geeigneten Umgebung aufgenommen. Schon ein kleines Lichtspiel kann die Effizienz des Systems verringern und zu hohen Ausfallraten führen.

2D wurde durch 3D-Erkennung ersetzt. Dieser neu aufkommende Trend bei Software verwendet ein 3D-Modell, um eine hochpräzise Gesichtserkennung zu ermöglichen. Durch die Aufnahme eines 3D-Bildes der Gesichtsoberfläche einer Person in Echtzeit hebt die Software charakteristische Merkmale hervor, bei denen Hartgewebe und Knochen am stärksten hervorstehen, z. B. die Kurven von Augenhöhle, Nase und Kinn, um das Motiv zu identifizieren. Diese Bereiche sind einzigartig und ändern sich im Laufe der Zeit nicht.

Durch die Verwendung der Tiefe und der Messachse, die nicht von der Beleuchtung beeinflusst werden, kann das 3D-Gesichtserkennungssystem sogar im Dunkeln verwendet werden und Objekte aus verschiedenen Winkeln (auch im Profil) erkennen. Eine solche Software durchläuft mehrere Phasen, um eine Person zu identifizieren:

- Erkennung: Erstellen eines Schnappschusses durch digitales Scannen eines vorhandenen Fotos (2D) oder Videos, um ein Livebild des Motivs (3D) zu erhalten.

- Zentrierung: Sobald das Gesicht erkannt wurde, markiert das System die Position, Größe und Haltung des Kopfes.

- Messung: Das System misst Kurven auf der Fläche millimetergenau und erstellt eine Vorlage.

- Darstellung: Das System übersetzt die Vorlage in einen eindeutigen Code. Dieser Code gibt jedem Muster eine Reihe von Zahlen, die Merkmale und Gesichtsmerkmale darstellen.

- Abgleich: Wenn das Bild in 3D vorliegt und die Datenbank 3D-Bilder enthält, erfolgt der Abgleich, ohne das Bild zu ändern. Wenn die Datenbank jedoch aus zweidimensionalen Bildern besteht, wird das dreidimensionale Bild in verschiedene Komponenten zerlegt (wie zweidimensionale Bilder derselben Gesichtsmerkmale aus verschiedenen Winkeln) und in 2D-Bilder konvertiert. Und dann wird die Übereinstimmung in der Datenbank gefunden.

- Überprüfung oder Identifizierung: Während des Überprüfungsprozesses wird ein Snapshot mit nur einem Snapshot in der Datenbank verglichen (1: 1). Wenn das Ziel die Identifizierung ist, wird der Schnappschuss mit allen Schnappschüssen in der Datenbank verglichen, was zu einer Reihe möglicher Übereinstimmungen führt (1: N). Die eine oder andere Methode wird nach Bedarf angewendet.

Wo werden Gesichtserkennungssysteme eingesetzt?

In der Vergangenheit haben Gesichtserkennungssysteme hauptsächlich in Strafverfolgungsbehörden Verwendung gefunden, da die Behörden sie verwendet haben, um zufällige Gesichter in Menschenmengen zu finden. Einige Regierungsbehörden haben ähnliche Systeme zur Sicherheit und zur Beseitigung von Wahlbetrug eingesetzt.

Es gibt jedoch viele andere Situationen, in denen solche Software populär wird. Systeme werden billiger, ihre Verbreitung wächst. Sie sind jetzt mit Kameras und Computern kompatibel, die von Banken und Flughäfen verwendet werden. Reisebüros arbeiten an einem Programm für erfahrene Reisende, um eine schnelle Sicherheitsüberprüfung für Passagiere durchzuführen, die freiwillig Informationen bereitstellen. Flughafenwarteschlangen werden schneller vorgerückt, wenn Personen ein Gesichtserkennungssystem durchlaufen, das Gesichter einer internen Datenbank zuordnet.

Andere mögliche Anwendungen sind Geldautomaten und Geldautomaten. Die Software kann das Gesicht des Kunden schnell überprüfen. Nach Erlaubnis des Kunden macht der Geldautomat oder das Terminal ein Bild des Gesichts. Die Software erstellt einen Gesichtsabdruck, der den Kunden vor Identitätsdiebstahl und betrügerischen Transaktionen schützt. Der Geldautomat gibt einer Person mit einem anderen Gesicht einfach kein Geld. Auch eine PIN ist nicht erforderlich.

Magie? Technologie!

Die Entwicklung der Gesichtserkennungstechnologie im Bereich der Banküberweisungen kann besonders wichtig und interessant sein. Vor kurzem hat die russische Bank Otkrytie ihre eigene einzigartige Lösung vorgestellt, die unter der Marke Open Garage entwickelt wurde: Überweisung von Geld von einem Foto in der mobilen Anwendung Otkritie.Transfers. Anstatt eine Karte oder Telefonnummer einzugeben, müssen Sie nur ein Foto der Person machen, die eine Überweisung vornehmen muss. Das Gesichtserkennungssystem vergleicht das Foto mit dem Referenzfoto (erfolgt, wenn die Bank die Karte ausstellt) und schlägt den Vor- und Nachnamen vor. Sie müssen lediglich eine Karte auswählen und den Betrag eingeben. Am wichtigsten ist, dass Kunden von Drittbanken diese Funktion auch für Überweisungen an Otkritie-Kunden verwenden können. Der Absender von Überweisungen kann eine Karte jeder russischen Bank verwenden.

„Die Verwendung eines Kundenfotos anstelle einer Bankkartennummer ist ein grundlegend neuer Ansatz für Online-Überweisungen, der auf der Verwendung eines Gesichtserkennungssystems für neuronale Netze basiert, mit dem ein Kunde anhand seiner biometrischen Daten mit einem hohen Maß an Genauigkeit identifiziert werden kann“, sagt der Leiter der Abteilung für die Entwicklung von Partnersystemen der Otkritie Bank Alexey Matveev. - Der Dienst eröffnet Benutzern völlig neue Lebensszenarien für Geldtransfers. Derzeit bietet keiner der Finanzmarktteilnehmer der Welt seinen Kunden einen solchen Service an. "

- gewährleistung der Sicherheit an überfüllten Orten;

- sicherheitssysteme, Vermeidung des illegalen Eindringens in die Website, Suche nach Eindringlingen;

- gesichtskontrolle im Catering- und Unterhaltungssegment, Suche nach verdächtigen und potenziell gefährlichen Besuchern;

- Überprüfung von Bankkarten;

- online-Zahlungen;

- kontextwerbung, digitales Marketing, Intelligent Signage und Digital Signage;

- fotoausrüstung;

- forensik;

- telefonkonferenzen;

- mobile Anwendungen;

- suche nach Fotos in großen Fotodatenbanken;

- markieren von Personen auf Fotos in sozialen Netzwerken und vielen anderen.

Panasonic installiert Gesichts- und Einkaufskameras im großen Supermarkt

Anfang April 2019 gab eine große japanische Supermarktkette FamilyMart den Beginn der Verwendung eines Gesichtserkennungssystems bekannt, mit dem Sie Einkäufe ohne Beteiligung von Kassierern bezahlen können. Mehr Details.

Sie können jetzt Fahrten in der chinesischen U-Bahn mit einer Person bezahlen

In britischen Gefängnissen erschien ein Gesichtserkennungssystem, um die Übertragung von "verbotenen" zu bekämpfen.

Anfang März 2019 wurde bekannt, dass in den britischen Gefängnissen Hull, Humber und Lindholm ein Gesichtserkennungssystem eingeführt wurde, mit dem die Weitergabe verbotener Gegenstände wie Mobiltelefone und Drogen bekämpft werden soll.

Im Jahr 2018 verzeichneten Gefängnisbeamte über 23.000 Fälle verbotener Übertragungen, 4.000 mehr als im Jahr 2017. Nach Angaben des Geheimdienstes beliefern einige Besucher mehrere Gefängnisse im ganzen Land mit Schmuggelware. Gleichzeitig erlaubt die Verwendung von Fingerabdrücken und die Überprüfung von Dokumenten ohne elektronische Kommunikation zwischen Gefängnissen keine Identifizierung solcher Verstöße.

Die im Gefängnis bewährte Biometrie- und Gesichtserkennungstechnologie verwendet IDScan und eine von Facewatch aus London entwickelte Software. Gefängnisse haben auch Iris-Scan-Technologie verwendet, die von Tascent, einem amerikanischen Unternehmen für biometrische Identifizierung und Sicherheit, entwickelt wurde.

Im HMP Humber Prison scannten Mitarbeiter sechs Wochen lang die Gesichter von 770 Besuchern, um festzustellen, wer zu unterschiedlichen Zeiten gefälschte Ausweise verwendete oder verschiedene Insassen besuchte. Mithilfe der neuen Sicherheitssysteme konnten Gefängnisbeamte eine Reihe verdächtiger Personen identifizieren, denen nach Ermittlungen möglicherweise die Einreise in britische Gefängnisse verweigert wurde. Darüber hinaus können die gesammelten Daten als Beweismittel für weitere Untersuchungen innerhalb und außerhalb des Gefängnisses dienen.

Diese Verwendung der Gesichtserkennung hat jedoch in einigen Bereichen der Gesellschaft zu Empörung geführt. Die britischen Aktivisten für bürgerliche Freiheiten, Big Brother Watch, haben beim Europäischen Gerichtshof für Menschenrechte eine Beschwerde gegen den Einsatz von Massenüberwachungstechnologie durch die britische Regierung eingereicht.

NEC führt Geldautomaten ein, mit denen Sie mithilfe der Gesichtserkennung Geld abheben können

Ende Februar 2019 gab die NEC Corporation die Einführung der weltweit ersten Geldautomaten bekannt, an denen Bargeld durch Gesichtserkennung abgehoben werden kann. Die Geldautomaten wurden in Zusammenarbeit mit der großen taiwanesischen Bank E.SUN Commercial Bank erstellt. Mehr Details.

IBM veröffentlicht 1 Million Gesichtsfotos für das biometrische Training

2018

Die Gesichtserkennung funktioniert nicht bei jedem zweiten Smartphone

Anfang Januar 2019 testete eine niederländische gemeinnützige Organisation 110 Smartphone-Modelle und stellte fest, dass die Gesichtserkennungsfunktion zum Sperren von Geräten bei mehr als jedem anderen Gerät nicht ordnungsgemäß funktionierte.

Eine Studie von Consumentenbond und seinen internationalen Partnern ergab, dass 42 der getesteten Smartphones mit einem Foto des Telefonbesitzers entsperrt werden konnten. Jedes Foto wird beispielsweise aus sozialen Netzwerken, von Überwachungskameras oder auf andere Weise aufgenommen.

Die Ergebnisse dieser Studie sind für Benutzer und Sicherheitsbehörden von Belang. Die Verwendung eines gedruckten Fotos des Gesichts des Trägers ist der erste Test der Gesichtserkennungsfunktion, die normale Benutzer und Tester verwenden. Vor allem ist dies der erste Trick, den Angreifer versuchen, sich in ein Face-to-Face-Smartphone zu hacken, bevor sie zu komplexeren Angriffen übergehen, bei denen Masken oder 3D-gedruckte Köpfe des Telefonbesitzers erstellt werden.

Jedes Gesichtserkennungssystem, das den "Fototest" nicht besteht, wird im Allgemeinen als nutzlos angesehen. Laut Consumentenbond haben Modelle von Asus, BlackBerry, Huawei, Lenovo, Nokia, Samsung, Sony und Xiaomi diese Tests nicht bestanden. Bei Sony haben absolut alle Modelle den Test nicht bestanden. Sechs weitere Modelle - Honor und sechs Modelle von LG - wurden nur im "strengen" Modus getestet. Während Benutzer aus diesem Test möglicherweise den Schluss ziehen, dass es sich nicht lohnt, die Gesichtserkennung zu aktivieren, haben 68 Geräte, darunter das Flaggschiff Apple iPhone XR, diesem einfachen Angriff standgehalten, ebenso wie viele andere leistungsstarke Android-Modelle von Samsung, Huawei, OnePlus und Honor.

Eine vollständige Liste der Modelle, die den Fototest bestanden haben, finden Sie auf der Consumentenbond-Website.

Die beliebtesten Gesichtserkennungssysteme in China

Eine der am häufigsten verwendeten Gesichtserkennungssoftware ist Face ++, mit der der Zugriff von den Bahnhöfen in Peking zum Bürogebäude in Alibaba überall kontrolliert wird.

Alibaba selbst hat eigene Systeme entwickelt, die in der U-Bahn von Shanghai eingesetzt werden, um Passagiere anhand ihres Gesichts und ihrer Stimme zu identifizieren.

Polizeibeamte, die die Sicherheit an einem chinesischen Bahnhof überwachen, tragen eine spezielle Sonnenbrille mit Gesichtserkennung. Das Gerät kann eine Person in 100 Millisekunden identifizieren und hat Strafverfolgungsbehörden mehr als einmal dabei geholfen, Kriminelle zu fangen.

Zum ersten Mal auf der Welt wurde in Shenzhen, China, eine Kamera für Fußgängerverletzungen eingeführt. Es ist an einer der belebten Kreuzungen der Stadt installiert und überwacht Personen, die die Straße überqueren, an einer roten Ampel. Die Kamera verwendet Gesichtserkennungstechnologie, um einen Eindringling zu identifizieren.

College-Aufnahmeprüfungen im ganzen Land verwenden Gesichts- und Fingerabdruckerkennung, um sicherzustellen, dass die Testteilnehmer echte Studenten sind.

Nach einer Reihe von Entführungen öffnen einige Kindergärten ihre Türen nur für Personen, deren Gesichter im System registriert sind. In einem der Kindergärten wurden über 200 Überwachungskameras installiert.

Sogar einige Toiletten haben Gesichtserkennungsgeräte. Die Maschine gibt höchstens alle neun Minuten 60 cm Toilettenpapier an eine Person aus.

In Alibaba gibt es bargeldlose Geschäfte von Hema, in denen Benutzer ihr Gesicht scannen und ihre Telefonnummer eingeben, um Zahlungen über Alipay zu tätigen.

Alibaba hat sich mit dem Hersteller von Hotelinformationssystemen Shiji zusammengetan, um ein Gesichtserkennungssystem für den Check-in in 50 Hotels zu installieren. Chinesische Touristen, die die Dienste des Online-Reisebüros Fliggy (im Besitz von Alibaba) nutzen, können zuerst ein Hotel darin buchen und dann mit ihrem "Gesicht" schnell im Hotel einchecken und eine Kaution hinterlegen.

Peking beschloss, die illegale Miete von Sozialwohnungen mit intelligenten Schlössern zu bekämpfen, die Eigentümer anhand ihres Gesichts erkennen

Ende Dezember 2018 wurde bekannt, dass intelligente Schlösser mit Gesichtserkennungstechnologie im öffentlichen Wohnungsbau in Peking beschleunigt eingeführt wurden. Mit ihrer Hilfe verstärken die lokalen Behörden die Maßnahmen gegen die illegale Weitervermietung von Sozialwohnungen, die Familien mit niedrigem Einkommen zu ermäßigten Preisen zur Verfügung gestellt werden.

Smart Lock mit Gesichtserkennung

Es wird erwartet, dass bis Ende Juni 2019 Schlösser mit einem eingebauten Gesichtsabtastsystem in allen Programmen zur Bereitstellung von subventioniertem Sozialwohnungsbau in Peking unter Beteiligung von 120.000 Mietern verwendet werden, berichtet die South China Morning Post unter Berufung auf The Beijing News.

Durch das Abgleichen von Informationen aus dem Scannen der Gesichter von Besuchern mit Bildern aus einer gespeicherten Datenbank erkennt das System Hosts und öffnet keine Türen für Fremde, sagte Shan Zhenyu, Direktor des Informationszentrums im Beijing State Housing Center, gegenüber Beijing News.

Darüber hinaus können mit dem System allein lebende ältere Menschen betreut werden. Wenn eine ältere Person das Haus für einen bestimmten Zeitraum nicht verlässt und nicht betritt, wird dem Immobilienverwalter eine Benachrichtigung über die Notwendigkeit eines Schecks gesendet.

In so großen Städten wie Peking sind Mietwohnungen sehr teuer. Im Durchschnitt kostet eine gemietete Wohnung in der Hauptstadt des Reiches der Mitte etwa 5.000 Yuan pro Monat (etwa 730 USD), während die Miete für Staatswohnungen weniger als 2.000 Yuan pro Monat (290 USD) betragen kann.

Die Pekinger Behörden hoffen, dass intelligente Schlösser, die Eigentümer an ihren Gesichtern erkennen, die Sicherheit erhöhen, illegale Untervermietungen verhindern und sicherstellen, dass nur Bedürftige davon profitieren.

Ab Ende 2018 werden in 47 Programmen intelligente Schlösser mit Gesichtserkennung verwendet, um bevorzugte Sozialwohnungen in Peking bereitzustellen. Mit ihrer Hilfe wurden etwa 100.000 gescannte Bilder der Gesichter von Mietern und ihren Familienmitgliedern erhalten.

Chinese Airbnb installiert intelligente Gesichtsschlösser in Privathaushalten

Misserfolg in London. Das Gesichtserkennungssystem in der U-Bahn erkennt niemanden

Ende Dezember 2018 wurde klar, dass das in der Londoner U-Bahn eingesetzte Gesichtserkennungssystem niemanden erkennen würde. Londoner Polizisten wurden dafür kritisiert, dass sie nicht gekennzeichnete Transporter verwendet haben, um kontroverse und ungenaue automatische Gesichtserkennungstechnologien von Weihnachtskäufern zu testen. Mehr Details.

Gesichtserkennungstoiletten in China reduzieren den Toilettenpapierverbrauch

Ende 2018 wurde bekannt, dass es in China immer mehr öffentliche Toiletten mit einem Gesichtserkennungssystem gibt, das Toilettenpapier spart.

Im Dezember wurde eine solche Toilette im Baotu Spring Park in der Stadt Jinan, Provinz Shandong, 400 km südlich von Peking, in Betrieb genommen. Diese Toilette verfügt über einen Automaten, der nach einem Gesichtsscan Toilettenpapier ausgibt. Bei einem Ansatz gibt das Gerät etwa 70 cm Papier aus. Um eine zusätzliche Portion Hygiene- und Hygieneprodukte zu erhalten, muss dieselbe Person 9 Minuten warten und ihren Kopf zur Identifizierung zurück zur Kamera bringen.

Um das Smartphone zu entsperren, drucken Hacker und Polizei 3D den Kopf des Besitzers

Gesichtserkennungssystem an 14 amerikanischen Flughäfen eingeführt

Am 20. August 2018 wurde an 14 amerikanischen Flughäfen ein Gesichtserkennungssystem eingeführt. Seine Wirksamkeit wurde von der US-Zoll- und Grenzschutzbehörde (CBP) gemeldet.

Laut der Website der Agentur legte am 26. August ein 26-jähriger Passagier, der von São Paulo (Brasilien) zum Flughafen Washington Dulles geflogen war, am Checkpoint einen französischen Pass vor. Das biometrische System ergab jedoch, dass das Gesicht des Mannes nicht mit dem Foto auf dem Dokument übereinstimmte.

Als der Neuankömmling in die USA zu einer zusätzlichen Suche geschickt wurde, war er "offensichtlich nervös" und, wie sich herausstellte, nicht umsonst. In seinem Schuh fanden sie einen Personalausweis im Namen eines Bürgers der Republik Kongo, der tatsächlich der Häftling war. Jetzt wird er inhaftiert, weil er versucht hat, unter falschen Dokumenten in die USA einzureisen.

Gesichtserkennungssysteme der britischen Polizei erwiesen sich als nutzlos

Im Mai 2018 wurde bekannt, dass die von der britischen Polizei verwendeten Gesichtserkennungssysteme große Probleme haben. Infolgedessen kann eine große Anzahl von Klagen eingereicht werden - dieses Thema ist zu einer "Priorität" für das Büro des Informationskommissars geworden, zitiert die BBC die Worte der Vertreterin der Regulierungsbehörde Elizabeth Denham.

Die britische Menschenrechtsorganisation Big Brother Watch veröffentlichte die Ergebnisse einer Studie, die eine "erstaunliche" Anzahl unschuldiger Menschen zeigte, aus denen die Gesichtserkennungstechnologie potenzielle Kriminelle gemacht hat.

Von Mai 2017 bis März 2018 gab das System 2.685 Übereinstimmungen von Personen mit der verdächtigen Datenbank für die Polizei in Südwales heraus, von denen sich jedoch 2.451 als falsch herausstellten.

Die Londoner Strafverfolgungsbehörden verwendeten beim Notting Hill Carnival 2017 Gesichtserkennungstechnologien. Die Messwerte des Systems erwiesen sich in 98% der Fälle als fehlerhaft, als das Signal ausgelöst wurde, dass ein Verdächtiger aus der Polizeidatenbank angeblich gesehen wurde. Die Lösung ist so angeordnet, dass bei Feststellung eines möglichen Gesetzesverstoßes ein Signal an den Schreibtisch des diensthabenden Beamten der nächstgelegenen Polizeistation gesendet wird.

Die Polizei beschuldigte die Kameras, die Bilder von geringer Qualität lieferten, und die Tatsache, dass das System zum ersten Mal verwendet wurde. Bei den nächsten 15 Veranstaltungen (Fußballspiele, Festivals, Paraden), bei denen die Technologie eingesetzt wurde, verbesserte sich das Ergebnis jedoch nicht. Nur bei drei hat das System nie einen Fehler gemacht.

Die Polizei sagte auch, dass in neun Monaten Betrieb des Gesichtserkennungssystems mehr als zweitausend Menschen korrekt identifiziert wurden, was zu 450 Festnahmen führte. Es wurde jedoch niemand fälschlicherweise inhaftiert. Dies liegt an der Tatsache, dass neben der Arbeit der Algorithmen auch Personen an der Arbeit beteiligt sind, die die positiven Ergebnisse überprüfen und die endgültigen Entscheidungen treffen.

Wissenschaftler haben eine neue Methode erfunden, um Gesichtserkennungssysteme zu betrügen

Gesichtserkennungssysteme werden von Tag zu Tag komplexer und werden zunehmend im allgegenwärtigen Leben eingesetzt. So hat Apple beispielsweise im vergangenen Jahr das iPhone X-Smartphone herausgebracht, das mit dem biometrischen System Face ID ausgestattet ist. Solche Systeme können jedoch insbesondere unter Verwendung von Infrarot-LEDs getäuscht werden. Infrarotstrahlen sind mit bloßem Auge nicht sichtbar, aber die meisten Kameras können Infrarotsignale aufnehmen.

Chinesische Forscher haben eine Baseballkappe entwickelt, die mit Miniatur-Infrarot-LEDs ausgestattet ist, die so platziert sind, dass die Infrarotstrahlen, die auf das Gesicht des Kopfbedeckungsträgers treffen, nicht nur dazu beitragen, ihre Identität zu verbergen, sondern auch "eine andere Person für die Gesichtsauthentifizierung zu verkörpern". ... Diese Aufgabe ist komplexer und erfordert die Verwendung eines tiefen neuronalen Netzwerks, um ein statisches Bild des Gesichts zu erkennen und Infrarotstrahlen korrekt auf das Gesicht des Betrügers zu projizieren.

Um ihre Theorie zu testen, verwendeten die Forscher Fotos von vier zufälligen Personen. In 70% der Fälle konnten sie Gesichtserkennungssysteme austricksen, vorausgesetzt, es gab eine leichte äußere Ähnlichkeit zwischen dem Opfer und dem Betrüger.

"Aufgrund unserer Ergebnisse und Angriffe können wir den Schluss ziehen, dass die heutigen Gesichtserkennungstechnologien in Bezug auf kritische Szenarien wie Authentifizierung und Überwachung kaum als sicher und zuverlässig bezeichnet werden können", folgerten die Forscher. Sie fügten hinzu, dass Infrarot-LEDs nicht nur in Baseballmützen, sondern auch in Regenschirmen, Haaren oder Perücken versteckt werden können.

Russische Zwillinge fordern von Apple 20 Millionen, weil das iPhone X den Unterschied zwischen ihnen nicht sieht

Zwillingsbrüder aus Vladimir - der 26-jährige Alexander und Ilya Tunchiki - schickten eine Klage an das russische Apple-Büro, da das Face-ID-System auf ihren iPhone X-Smartphones beide jungen Menschen identisch identifiziert und damit ihrer Meinung nach Verletzung des Schutzes personenbezogener Daten.

Beleidigte Benutzer fordern, dass das Unternehmen die Technologie verbessert und moralische Schäden in Höhe von 20 Millionen Rubel kompensiert, sagte Roman Ardykutsa, ein Anwalt, der die Interessen der Brüder vertritt, gegenüber TASS im Januar 2018.

„Die Zwillinge haben ... das iPhone X gekauft, um die Funktion zum Entsperren des Gesichts genau zu nutzen. Zu ihrer Enttäuschung erkennt jedes Gerät beide Brüder, vor denen sie beim Kauf nicht gewarnt wurden. Diese Informationen fehlen in der Anleitung. Aus diesem Grund fordern die Antragsteller das Unternehmen auf, die Technologie zu verfeinern “, erklärte er.

2017

Gesichtserkennung im Einzelhandel

Im November 2017 sendete CNBC eine Geschichte über die Implementierung von Gesichtserkennungssystemen in Geschäften. Einzelhändler verwenden diese Technologien, um Kundendaten zu sammeln und Angebote basierend auf den relevanten Daten anzupassen.

Im Einzelhandel wird die Gesichtserkennung hauptsächlich verwendet, um Kunden zu motivieren. Wenn beispielsweise eine Person am Eingang des Geschäfts erkannt wird und ihre Kaufhistorie angezeigt wird, wissen die Mitarbeiter des Geschäfts besser, was sie anbieten sollen. Wenn er also einen Fernseher in einem Elektronikgeschäft gekauft hat, erkennt ihn der Mitarbeiter, spricht ihn mit Namen an und bietet an, eine neue Fernbedienung zu kaufen.

Laut dem in Hongkong ansässigen IT-Unternehmen Jardine One Solution (JOS) verwenden viele Einzelhändler die Gesichtserkennung, um Daten über ihre Ladenbesucher zu sammeln.

JOS selbst unterstützt Einzelhändler bei der Gesichtserkennung, um Kunden zu profilieren und ihre Aktionen am Point of Sale zu verfolgen. Wir sprechen über Daten wie die Anzahl der Besucher, ihr Alter, Geschlecht, ethnische Zugehörigkeit. Diese Informationen helfen den Geschäften, den Kundenfluss besser zu verstehen und personalisierte Angebote für sie zu erstellen, sagte Lant.

Mithilfe der Analyse von Daten, die von Gesichtserkennungssystemen stammen, können Sie beispielsweise die Musik auswählen, die in der Verkaufsfläche abgespielt wird.

Laut JOS sind alle empfangenen Kundendaten anonym, das Thema Vertraulichkeit bleibt jedoch relevant. Technologie behindert die Einführung solcher Systeme nicht, aber es gibt Bedenken hinsichtlich Identität und Kultur, räumt Mark Lant ein.

Er fügte hinzu, dass Einzelhändler viel Geld für die Verhinderung von Datenverlust und den Schutz von Informationen ausgeben. Der Skandal um den Datendiebstahl von Millionen von Uber-Kunden zeigt, dass sich Unternehmen nicht sicher fühlen können und Benutzer bei der Offenlegung persönlicher Informationen Vorsicht walten lassen müssen, sagte der Geschäftsführer von JOS.

Mark Ryski, Gründer und CEO von HeadCount, einem Unternehmen, das Nachverfolgungs- und Verkehrsverbesserungsdienste anbietet, sagt, dass Biometrie, einschließlich der von Gesichtserkennungssystemen erzeugten, sensibel ist und ein großes Potenzial hat - insbesondere in um die Sicherheit zu gewährleisten und die Qualität des Kundendienstes zu verbessern.

Brennan Wilkie, Senior Vice President für Kundenservice-Strategie bei InMoment, sagt, dass es im Einzelhandel tatsächlich viel Potenzial für Gesichtserkennung gibt. Beispielsweise können solche Geräte den Gesichtsausdruck eines Kunden in einem Geschäft mit Daten über ihn, seine Markentreue und andere Einkäufe abgleichen. Um das Problem der Privatsphäre der Benutzer abzumildern, müssen die Geschäfte den Kunden nachweisen, welche Vorteile sie erhalten, wie dies bei Self-Service-Kassen oder bei Bankkarten mit Chips der Fall war.

Nach der Prognose des Analyseunternehmens MarketsandMarkets wird der weltweite Markt für Gesichtserkennungssysteme bis 2021 6,8 Milliarden US-Dollar erreichen.

Das IPhone X-Gesichts-Login wurde mit einer 150-Dollar-Maske gehackt. Video

In fast 90 Prozent der Fälle konnten Forscher einen weißen Mann für Milla Jovovich ausgeben. Eine Frau mit asiatischem Aussehen in speziellen Gläsern wurde im gleichen Prozentsatz der Fälle mit einem Mann aus dem Nahen Osten verwechselt.

Darüber hinaus haben sie ihre Methode mit der kommerziellen Software Face ++ ausprobiert, mit der Alibaba Zahlungen autorisiert. In diesem Fall stellten sie keine Person mit Brille vor die Kamera, sondern machten zuerst ein Foto von ihr mit Brille und luden es dann in das Programm hoch. Infolgedessen gelang es ihnen, eine Person für weitere 100 Prozent der Zeit weiterzugeben.

Öffentliche Organisationen in den USA gegen Gesichtserkennung

Eine Koalition von 52 Organisationen der Zivilgesellschaft und der Menschenrechte hat einen Brief an das Justizministerium geschickt, in dem das Justizministerium gebeten wurde, den übermäßigen Einsatz von Gesichtserkennungstechnologien in Strafverfolgungsbehörden zu untersuchen. Die Koalition ist auch besorgt über die ungleichmäßige Genauigkeit der maschinellen Erkennung von Gesichtern verschiedener Rassen, die die Grundlage für die Manifestation von Rassismus seitens der Mitarbeiter der Behörden werden kann.

Diese Technologien werden insbesondere von der örtlichen Polizei, der Staatspolizei und dem FBI missbraucht, heißt es in dem Brief. Die Koalition fordert das Justizministerium auf, zunächst die bereits untersuchten Polizeidienststellen im Zusammenhang mit der Voreingenommenheit gegenüber Bürgern mit nicht weißer Hautfarbe zu überprüfen.

Die Anfrage basierte auf einer Studie des Datenschutz- und Technologiezentrums der Georgetown University School of Law. Die Studie ergab, dass die Gesichter der Hälfte der erwachsenen US-Bevölkerung unter verschiedenen Umständen mit einer staatlichen Identifikationssoftware gescannt wurden.

Die Forscher stellen fest, dass es in den Vereinigten Staaten heute keine ernsthaften Regeln für die Verwendung dieser Software gibt. Laut Alvaro Bedoya, Direktor des Zentrums und Mitautor der Studie, befindet sich eine Person, die auf einem Führerschein fotografiert wurde, bereits in der Datenbank der Polizei oder des FBI. Dies ist besonders wichtig, da die Gesichtserkennung ungenau sein und in diesem Fall unschuldigen Bürgern schaden kann.

Beispiele für Projekte in HSBC, MasterCard und Facebook

Der Service wird für Firmenkunden von NSBC verfügbar sein. Über die mobile Banking-App können sie mit einem Klick auf ein Selfie Konten eröffnen. Die Bank bestätigt auch die Identität des Kunden mithilfe eines Gesichtserkennungsprogramms. Das Foto wird mit den zuvor auf das System hochgeladenen Bildern verglichen, z. B. aus einem Reisepass oder Führerschein. Es wird davon ausgegangen, dass der neue Dienst das Speichern digitaler Codes überflüssig macht und die Identifikationszeit verkürzt.

Um diese Option nutzen zu können, müssen Benutzer eine spezielle Anwendung auf ihren Computer, ihr Tablet oder ihr Smartphone herunterladen. Schauen Sie dann in die Kamera oder verwenden Sie den Fingerabdruckleser des Geräts (falls auf dem Gerät verfügbar). (Zumindest für den Moment) müssen Benutzer jedoch noch zusätzlich ihre Bankkartendaten angeben. Nur wenn eine zusätzliche Identifikation erforderlich ist, können Benutzer die oben genannte Option verwenden.

Mit diesem neuen Ansatz beabsichtigt MasterCard, Benutzer vor gefälschten Online-Transaktionen zu schützen, die mit gestohlenen Benutzerkennwörtern ausgeführt werden, und Benutzern ein bequemeres Authentifizierungssystem zur Verfügung zu stellen. Das Unternehmen gab an, dass 92% der Personen, die dieses neue System getestet haben, es herkömmlichen Passwörtern vorziehen.

Einige Experten stellen den Schutz von Informationen vor Cyberkriminellen in Frage, die nicht einfach Fingerabdrücke oder ein Foto seines Gesichts erhalten können, wenn die Transaktion über ein unsicheres öffentliches Wi-Fi-Netzwerk ausgeführt wird.

Cyber-Sicherheitsexperten argumentieren, dass das System mehrere Sicherheitsebenen umfassen sollte, um einen möglichen Diebstahl von Fotos von Benutzergesichtern zu verhindern. Online-Zahlungen sind schließlich ein attraktives Ziel für Cyberkriminelle.

Ende 2015 demonstrierte eine Expertengruppe der Technischen Universität Berlin die Möglichkeit, den PIN-Code jedes Smartphones mit dem Selfie des Benutzers zu extrahieren. Dazu lesen sie diesen Code, der in den Augen des Benutzers angezeigt wurde, als er ihn auf seinem OPPO N1-Telefon eingab. Für einen Hacker reicht es aus, einfach die Kontrolle über die Frontkamera des Smartphones zu übernehmen, um diesen elementaren Angriff auszuführen. Könnte ein Cyberkrimineller die Kontrolle über das Gerät eines Benutzers übernehmen, ein Selfie machen und dann Online-Zahlungen mit dem eingegebenen Passwort ausführen, das der Hacker in den Augen seines Opfers gesehen hat?

MasterCard besteht darauf, dass seine Sicherheitsmechanismen dieses Verhalten erkennen können. Beispielsweise müssten Benutzer blinken, damit die App ein „Live“ -Bild einer Person anstelle eines Fotos oder eines vorab aufgenommenen Videos anzeigt. Das System vergleicht das Gesichtsbild des Benutzers, konvertiert es in einen Code und überträgt es über ein sicheres Protokoll über das Internet an MasterCard. Das Unternehmen verspricht, dass diese Informationen sicher auf seinen Servern gespeichert werden, während das Unternehmen selbst das Gesicht des Benutzers nicht rekonstruieren kann.

Im Sommer 2016 wurde bekannt, dass die Forscher haben das biometrische Authentifizierungssystem mithilfe eines Fotos von Facebook umgangen. Der Angriff wurde durch die potenziellen Schwachstellen der sozialen Ressourcen ermöglicht.

Ein Forscherteam der North Carolina State University hat eine Methode zur Umgehung von Sicherheitssystemen demonstriert, die auf Gesichtserkennungstechnologie basieren, wobei zugängliche Fotos von Nutzern sozialer Medien verwendet werden. Wie im Bericht von Spezialisten erläutert, wurde der Angriff aufgrund der potenziellen Schwachstellen in den sozialen Ressourcen möglich.

„Es ist keine Überraschung, dass in sozialen Medien veröffentlichte persönliche Fotos eine Bedrohung für die Privatsphäre darstellen können. Die meisten großen sozialen Netzwerke empfehlen Benutzern, beim Posten von Fotos auf der Website Datenschutzeinstellungen festzulegen. Viele dieser Bilder sind jedoch häufig für die breite Öffentlichkeit verfügbar oder können nur von Freunden angezeigt werden. Darüber hinaus können Benutzer die Verfügbarkeit ihrer von anderen Abonnenten veröffentlichten Fotos nicht unabhängig steuern “, stellen die Wissenschaftler fest.

Im Rahmen des Experiments wählten die Forscher Fotos von 20 Freiwilligen (Nutzer von Facebook, Google+, LinkedIn und anderen sozialen Ressourcen) aus. Anschließend verwendeten sie diese Bilder, um 3D-Gesichtsmodelle zu erstellen, sie mit einer Reihe von Animationseffekten zu animieren, eine Hautstruktur auf das Modell anzuwenden und das Aussehen (falls erforderlich) zu optimieren. Die Forscher testeten die resultierenden Modelle auf fünf Sicherheitssystemen, von denen vier in 55-85% der Fälle betrogen wurden.

Laut Unternehmensbericht Technavo (Winter 216) einer der wichtigsten Trends, die sich positiv auf den Markt für biometrische Gesauswirken ( gesichtserkennung) ist die Einführung multimodaler biometrischer Systeme in Sektoren wie Gesundheitswesen, Bankwesen, Finanzsektor, Wertpapier- und Versicherungssektor, Transportsektor, Straßenverkehr sowie im öffentlichen Sektor.

Der Gründer des Projekts, Benjamin Levy, sagte, dass IsItYou aufgrund des hohen Sicherheitsniveaus 99.999 von 100.000 Fällen von Täuschung erkennen kann. Levy versuchte die Banken bereits im nächsten Jahr von der Notwendigkeit zu überzeugen, sein System zu implementieren. Es wird zur Durchführung von Finanztransaktionen verwendet.

Google verwendet die Gesichtserkennungsfunktion bereits in Android. Auf diese Weise können Sie das Gerät entsperren, auf dem dieses mobile Betriebssystem ausgeführt wird. Die Entwickler haben jedoch wiederholt argumentiert, dass die Gesichtserkennung im Vergleich zu klassischen Methoden nicht sicher genug ist. In dieser Hinsicht bezweifelten Experten die Behauptungen von Benjamin Levy.

Marios Savvedes von der Carnegie Mellon University erforscht die Gesichtserkennung. Er glaubt, dass ein selbst durchgeführter IsItYou-Sicherheitstest nicht zuverlässig sein kann.

Die gleiche Meinung teilt der Weltexperte auf dem Gebiet der Biometrie, Dr. Massimo Tistarelli (Massimo Tistarelli). Er sagte, dass in Europa ein umfassendes wissenschaftliches Projekt Tabula Rasa im Gange sei, dessen Hauptziel darin bestehe, einen Betrugsbekämpfungsschutz für biometrische Identifizierungsmethoden zu entwickeln. Ihm zufolge sollten vor dem Markteintritt eine Reihe unabhängiger Studien durchgeführt werden, um die Wirksamkeit des Produkts zu bestätigen.

Mit beneidenswerter Regelmäßigkeit erscheinen auf Habré Artikel, die über bestimmte Methoden der Gesichtserkennung berichten. Wir haben uns entschlossen, dieses wunderbare Thema nicht nur zu unterstützen, sondern auch unser internes Dokument zu veröffentlichen, das zwar nicht alle, sondern viele Ansätze zur Gesichtserkennung, ihre Stärken und Schwächen abdeckt. Es wurde von Andrey Gusak, unserem Ingenieur, für junge Mitarbeiter der Bildverarbeitungsabteilung sozusagen zu Ausbildungszwecken zusammengestellt. Heute bieten wir es allen an. Am Ende des Artikels - eine beeindruckende Liste von Referenzen für die Neugierigsten.

Mit beneidenswerter Regelmäßigkeit erscheinen auf Habré Artikel, die über bestimmte Methoden der Gesichtserkennung berichten. Wir haben uns entschlossen, dieses wunderbare Thema nicht nur zu unterstützen, sondern auch unser internes Dokument zu veröffentlichen, das zwar nicht alle, sondern viele Ansätze zur Gesichtserkennung, ihre Stärken und Schwächen abdeckt. Es wurde von Andrey Gusak, unserem Ingenieur, für junge Mitarbeiter der Bildverarbeitungsabteilung sozusagen zu Ausbildungszwecken zusammengestellt. Heute bieten wir es allen an. Am Ende des Artikels - eine beeindruckende Liste von Referenzen für die Neugierigsten.

Also fangen wir an.

Trotz der Vielzahl der vorgestellten Algorithmen kann die allgemeine Struktur des Gesichtserkennungsprozesses unterschieden werden:

Der allgemeine Prozess der Verarbeitung eines Gesichtsbildes während der Erkennung

In der ersten Phase wird das Gesicht erkannt und im Bild lokalisiert. Im Stadium der Erkennung wird das Gesichtsbild ausgerichtet (geometrisch und hell), die Merkmale werden berechnet und die Erkennung selbst wird durchgeführt - die berechneten Merkmale werden mit den in der Datenbank gespeicherten Standards verglichen. Der Hauptunterschied zwischen allen vorgestellten Algorithmen besteht in der Berechnung von Merkmalen und dem Vergleich ihrer Sammlungen miteinander.

1. Die Methode des flexiblen Vergleichs von Graphen (Elastic Graph Matching).

Das Wesentliche der Methode ist der elastische Vergleich von Graphen, die Gesichtsbilder beschreiben. Flächen werden als Diagramme mit gewichteten Eckpunkten und Kanten dargestellt. Im Stadium der Erkennung bleibt einer der Graphen - der Referenzgraph - unverändert, während der andere deformiert wird, um den ersten am besten anzupassen. In solchen Erkennungssystemen können Graphen entweder ein rechteckiges Gitter oder eine Struktur sein, die durch charakteristische (anthropometrische) Punkte des Gesichts gebildet wird.

UND)

B)

Ein Beispiel für eine Diagrammstruktur zur Gesichtserkennung: a) ein reguläres Gitter b) ein Diagramm, das auf den anthropometrischen Punkten des Gesichts basiert.

An den Scheitelpunkten des Diagramms werden die Werte von Merkmalen berechnet. Meistens verwenden sie die komplexen Werte von Gabor-Filtern oder deren geordneten Mengen - Gabor-Wavelets (Gabor-Systeme), die in einem lokalen Bereich des Scheitelpunkts des Diagramms lokal berechnet werden, indem die Helligkeitswerte von Pixeln mit Gabor-Filtern gefaltet werden.

Set (Bank, Jet) von Gabor-Filtern

Beispiel für die Faltung eines Gesichtsbildes mit zwei Gabor-Filtern

Die Kanten des Diagramms werden mit dem Abstand zwischen benachbarten Scheitelpunkten gewichtet. Die Differenz (Abstand, Unterscheidungsmerkmal) zwischen zwei Graphen wird unter Verwendung einer bestimmten Preisverformungsfunktion berechnet, die sowohl die Differenz zwischen den Werten der an den Eckpunkten berechneten Merkmale als auch den Verformungsgrad der Graphenkanten berücksichtigt.

Die Verformung des Graphen erfolgt, indem jeder seiner Scheitelpunkte in bestimmten Richtungen relativ zu seiner ursprünglichen Position um einen gewissen Abstand verschoben wird und eine solche Position gewählt wird, an der der Unterschied zwischen den Werten von Merkmalen (Antworten von Gabor-Filtern) am Scheitelpunkt des deformierten Graphen und dem entsprechenden Scheitelpunkt des Referenzgraphen minimal ist. Diese Operation wird abwechselnd für alle Eckpunkte des Diagramms ausgeführt, bis die kleinste Gesamtdifferenz zwischen den Merkmalen des verformbaren Diagramms und dem Referenzdiagramm erreicht ist. Der Wert der Preisverformungsfunktion an dieser Position des verformbaren Diagramms ist ein Maß für die Differenz zwischen dem eingegebenen Gesichtsbild und dem Referenzdiagramm. Dieses "Relaxations" -Verformungsverfahren muss für alle in der Systemdatenbank gespeicherten Referenzflächen durchgeführt werden. Das Systemerkennungsergebnis ist ein Standard mit dem besten Wert der Preisverformungsfunktion.

Ein Beispiel für die Verformung eines Graphen in Form eines regelmäßigen Gitters

Einige Veröffentlichungen weisen auf eine Erkennungseffizienz von 95 bis 97% hin, selbst wenn verschiedene emotionale Ausdrücke vorhanden sind und der Gesichtswinkel um bis zu 15 Grad geändert wird. Die Entwickler elastischer Vergleichssysteme in Graphen führen jedoch die hohen Rechenkosten dieses Ansatzes an. Um beispielsweise das eingegebene Gesichtsbild mit 87 Referenzbildern zu vergleichen, dauerte es ungefähr 25 Sekunden, wenn auf einem Parallelcomputer mit 23 Übertragern gearbeitet wurde (Hinweis: Die Veröffentlichung stammt aus dem Jahr 1993). In anderen Veröffentlichungen zu diesem Thema wird die Zeit entweder nicht angegeben oder es wird gesagt, dass sie lang ist.

Nachteile: hohe rechnerische Komplexität des Erkennungsverfahrens. Geringe Herstellbarkeit beim Auswendiglernen neuer Standards. Lineare Abhängigkeit der Laufzeit von der Größe der Gesichtsdatenbank.

2. Neuronale Netze

Derzeit gibt es etwa ein Dutzend Arten von neuronalen Netzen (NN). Eine der am häufigsten verwendeten Optionen ist ein Netzwerk, das auf einem mehrschichtigen Perzeptron basiert und es Ihnen ermöglicht, das Eingangsbild / -signal gemäß der Voreinstellung / dem Training des Netzwerks zu klassifizieren.

Neuronale Netze werden anhand einer Reihe von Trainingsbeispielen trainiert. Die Essenz des Trainings besteht darin, die Gewichte der interneuronalen Verbindungen anzupassen, um ein Optimierungsproblem mithilfe der Gradientenabstiegsmethode zu lösen. Beim Erlernen des neuronalen Netzwerks werden Schlüsselmerkmale automatisch extrahiert, ihre Bedeutung bestimmt und Beziehungen zwischen ihnen aufgebaut. Es wird davon ausgegangen, dass ein ausgebildeter NN die im Lernprozess gewonnenen Erfahrungen aufgrund verallgemeinernder Fähigkeiten auf unbekannte Bilder anwenden kann.

Die besten Ergebnisse auf dem Gebiet der Gesichtserkennung (gemäß den Ergebnissen der Analyse von Veröffentlichungen) wurden vom Convolutional Neural Network oder Convolutional Neural Network (im Folgenden - CNN) gezeigt, was eine logische Weiterentwicklung der Ideen von Architekturen neuronaler Netze wie Cognitron und Neocognitron darstellt. Der Erfolg beruht auf der Fähigkeit, die zweidimensionale Topologie des Bildes im Gegensatz zum mehrschichtigen Perzeptron zu berücksichtigen.

Unterscheidungsmerkmale von SNS sind lokale Rezeptorfelder (lokale zweidimensionale Konnektivität von Neuronen), Gesamtgewichte (Erkennung einiger Merkmale an einer beliebigen Stelle im Bild) und hierarchische Organisation mit räumlicher Unterabtastung. Dank dieser Innovationen bietet der SNS einen teilweisen Widerstand gegen Änderungen des Maßstabs, der Verschiebung, der Drehung, des Perspektivwechsels und anderer Verzerrungen.

Schematische Darstellung der Architektur eines Faltungsnetzwerks

Das Testen des SNS basierend auf der ORL-Datenbank, die Bilder von Gesichtern mit kleinen Änderungen in Beleuchtung, Skalierung, räumlichen Rotationen, Position und verschiedenen Emotionen enthielt, ergab eine Erkennungsgenauigkeit von 96%.

SNS erhielt ihre Entwicklung in der Entwicklung von DeepFace, das von übernommen wurde

Facebook, um die Gesichter der Nutzer seines sozialen Netzwerks zu erkennen. Alle architektonischen Merkmale sind geschlossen.

Wie DeepFace funktioniert

Nachteile neuronaler Netze: Das Hinzufügen einer neuen Referenzperson zur Datenbank erfordert eine vollständige Umschulung des Netzwerks für den gesamten verfügbaren Satz (ein ziemlich langwieriger Vorgang, abhängig von der Stichprobengröße, von 1 Stunde bis zu mehreren Tagen). Mathematische Probleme im Zusammenhang mit dem Training: Erreichen des lokalen Optimums, Auswahl des optimalen Optimierungsschritts, Umschulung usw. Eine schwierig zu formalisierende Phase bei der Auswahl einer Netzwerkarchitektur (Anzahl der Neuronen, Schichten, Art der Verbindungen). Zusammenfassend können wir daraus schließen, dass die NS eine "Black Box" mit schwer zu interpretierenden Ergebnissen ist.

3. Versteckte Markov-Modelle (CMM, HMM)

Eine der statistischen Methoden zur Gesichtserkennung sind Hidden-Markov-Modelle (HMM) mit diskreter Zeit. HMM nutzt die statistischen Eigenschaften von Signalen und berücksichtigt deren räumliche Eigenschaften direkt. Die Elemente des Modells sind: eine Menge versteckter Zustände, eine Menge beobachteter Zustände, eine Matrix von Übergangswahrscheinlichkeiten, eine anfängliche Wahrscheinlichkeit von Zuständen. Jedes hat sein eigenes Markov-Modell. Beim Erkennen eines Objekts werden die für eine bestimmte Objektbasis generierten Markov-Modelle überprüft und die maximal beobachtbare Wahrscheinlichkeit ermittelt, dass die Beobachtungssequenz für ein bestimmtes Objekt vom entsprechenden Modell generiert wird.

Bisher war es nicht möglich, ein Beispiel für eine kommerzielle Anwendung von SMM zur Gesichtserkennung zu finden.

Nachteile:

- Es ist notwendig, die Parameter des Modells für jede Datenbank auszuwählen.

- HMM hat keine Unterscheidungsfähigkeit, dh der Lernalgorithmus maximiert nur die Reaktion jedes Bildes auf sein eigenes Modell, minimiert jedoch nicht die Reaktion auf andere Modelle.

4. Hauptkomponentenanalyse (PCA)

Eine der bekanntesten und am weitesten entwickelten Methoden ist die PCA-Methode (Principal Component Analysis), die auf der Karunen-Loev-Transformation basiert.

Anfänglich wurde die Hauptkomponentenanalyse in Statistiken angewendet, um den Merkmalsraum ohne signifikanten Informationsverlust zu reduzieren. Bei dem Problem der Gesichtserkennung wird es hauptsächlich verwendet, um ein Gesichtsbild mit einem Vektor kleiner Dimension (Hauptkomponenten) darzustellen, das dann mit den in der Datenbank gespeicherten Referenzvektoren verglichen wird.

Das Hauptziel der Hauptkomponentenmethode besteht darin, die Dimension des Merkmalsraums so zu reduzieren, dass die „typischen“ Bilder vieler Personen so gut wie möglich beschrieben werden. Mit dieser Methode ist es möglich, verschiedene Variabilitäten in der Trainingsprobe von Gesichtsbildern zu identifizieren und diese Variabilität anhand mehrerer orthogonaler Vektoren zu beschreiben, die als Eigengesichter bezeichnet werden.

Der Satz von Eigenvektoren, der einmal auf der Trainingsprobe von Gesichtsbildern erhalten wurde, wird verwendet, um alle anderen Gesichtsbilder zu codieren, die durch eine gewichtete Kombination dieser Eigenvektoren dargestellt werden. Unter Verwendung einer begrenzten Anzahl von Eigenvektoren ist es möglich, eine komprimierte Approximation des eingegebenen Gesichtsbildes zu erhalten, die dann in der Datenbank als Koeffizientenvektor gespeichert werden kann, der gleichzeitig als Suchschlüssel in der Gesichtsdatenbank dient.

Das Wesen der Hauptkomponentenmethode ist wie folgt. Zunächst wird der gesamte Trainingssatz von Gesichtern in eine gemeinsame Datenmatrix konvertiert, wobei jede Zeile eine Instanz des in eine Zeile zerlegten Gesichtsbilds ist. Alle Gesichter des Trainingssatzes sollten auf die gleiche Größe und mit normalisierten Histogrammen reduziert werden.

Transformieren des Trainingssatzes von Gesichtern in eine gemeinsame Matrix X.

Dann werden die Daten normalisiert und die Zeilen auf den 0. Mittelwert und die 1. Varianz reduziert, und die Kovarianzmatrix wird berechnet. Für die erhaltene Kovarianzmatrix ist das Problem der Bestimmung der Eigenwerte und der entsprechenden Eigenvektoren (Eigenwerte) gelöst. Als nächstes werden die Eigenvektoren in absteigender Reihenfolge der Eigenwerte sortiert und nur die ersten k Vektoren bleiben gemäß der Regel übrig:

PCA-Algorithmus

Ein Beispiel für die ersten zehn Eigenvektoren (Eigenwerte), die auf dem trainierten Satz von Gesichtern erhalten wurden

= 0.956*

= 0.956* -1.842*

-1.842* +0.046

+0.046  …

…

Ein Beispiel für die Konstruktion (Synthese) eines menschlichen Gesichts unter Verwendung einer Kombination aus eigenen Gesichtern und Hauptkomponenten

Prinzip der Auswahl einer Basis aus den ersten besten Eigenvektoren

Ein Beispiel für die Abbildung eines Gesichts in einen dreidimensionalen metrischen Raum, erhalten aus drei eigenen Gesichtern und weitere Erkennung

Die Hauptkomponentenmethode hat sich in der Praxis bewährt. In Fällen, in denen sich die Beleuchtung oder der Gesichtsausdruck im Gesichtsbild erheblich ändert, nimmt die Wirksamkeit der Methode jedoch erheblich ab. Der Punkt ist, dass die PCA einen Unterraum mit dem Ziel wählt, den Eingabedatensatz so weit wie möglich zu approximieren und nicht zwischen Personenklassen zu unterscheiden.

In der vorgeschlagenen Lösung für dieses Problem unter Verwendung der linearen Fisher-Diskriminante (in der Literatur gibt es einen Namen "Eigen-Fisher", "Fisherface", LDA). LDA wählt einen linearen Unterraum, der das Verhältnis maximiert:

Wo ![]()

Interclass Scatter Matrix und

Klasseninterne Streumatrix; m ist die Anzahl der Klassen in der Datenbank.

LDA sucht nach einer Datenprojektion, die die Klassen so linear wie möglich trennbar macht (siehe Abbildung unten). Zum Vergleich sucht die PCA nach einer Datenprojektion, die die Verteilung über die gesamte Gesichtsdatenbank (ohne Klassen) maximiert. Experimente mit starker Tank- und Bodenschattierung von Gesichtsbildern zeigten, dass Fisherface zu 95% wirksam war, verglichen mit 53% Eigenface.

Der grundlegende Unterschied zwischen der Bildung von Projektionen PCA und LDA

Unterschied zwischen PCA und LDA

5. Aktive Erscheinungsmodelle (AAM) und aktive Formmodelle (ASM) ()

Active Appearance Models (AAM)Active Appearance Models (AAM) sind statistische Bildmodelle, die durch verschiedene Verformungen an das reale Bild angepasst werden können. Diese Art von zweidimensionalem Modell wurde 1998 von Tim Coots und Chris Taylor vorgeschlagen. Anfänglich wurden aktive Erscheinungsmodelle verwendet, um die Parameter von Gesichtsbildern abzuschätzen.

Das aktive Erscheinungsmodell enthält zwei Arten von Parametern: Parameter in Bezug auf die Form (Formparameter) und Parameter in Bezug auf das statistische Pixelmodell eines Bildes oder einer Textur (Erscheinungsparameter). Das Modell muss vor der Verwendung auf einer Reihe von vorbeschrifteten Bildern trainiert werden. Bilder werden manuell markiert. Jedes Etikett hat eine eigene Nummer und definiert einen charakteristischen Punkt, den das Modell bei der Anpassung an ein neues Bild finden muss.

Ein Beispiel für eine Gesichtsbildmarkierung von 68 Punkten, die eine AAM-Form bilden.

Die AAM-Trainingsroutine beginnt mit der Normalisierung der Formen in den zugeordneten Bildern, um Unterschiede in Skalierung, Neigung und Versatz auszugleichen. Hierzu wird die sogenannte generalisierte Procrustian-Analyse verwendet.

Die Koordinaten der Punkte der Gesichtsform vor und nach der Normalisierung

Die Hauptkomponenten werden dann unter Verwendung der PCA-Methode aus dem Satz normalisierter Punkte extrahiert.

Das AAM-Formmodell besteht aus einem Triangulationsgitter s0 und einer linearen Kombination von Verschiebungen si relativ zu s0

Ferner wird eine Matrix aus den Pixeln innerhalb der Dreiecke gebildet, die durch die Punkte der Form gebildet werden, so dass jede ihrer Spalten die Pixelwerte der entsprechenden Textur enthält. Es ist erwähnenswert, dass die für das Training verwendeten Texturen entweder einkanalig (Graustufen) oder mehrkanalig sein können (z. B. RGB-Farbraum oder andere). Im Fall von Mehrkanaltexturen werden Pixelvektoren für jeden der Kanäle separat gebildet und dann verkettet. Nachdem die Hauptkomponenten der Texturmatrix gefunden wurden, wird das AAM-Modell als trainiert betrachtet.

Das Erscheinungsmodell von AAM besteht aus einer Basisansicht A0, die durch Pixel innerhalb eines Basisgitters s0 definiert ist, und einer linearen Kombination von Ais Offsets relativ zu A0

Ein Beispiel für die Ausarbeitung von AAM. Formparametervektor

p \u003d (p_1, p_2, 〖…, p〗 _m) ^ T \u003d (- 54,10, -9,1,…) ^ T wird verwendet, um ein Modell der Form s zu synthetisieren, und der Parametervektor λ \u003d (λ_1, λ_2, 〖…, λ〗 _m) ^ T \u003d (3559,351, -256,…) ^ T zur Synthese des Erscheinungsbilds des Modells. Das endgültige Gesichtsmodell 〖M (W (x; p))〗 ^ wird als Kombination zweier Modelle erhalten - Form und Aussehen.

Die Anpassung des Modells an ein bestimmtes Gesichtsbild erfolgt bei der Lösung eines Optimierungsproblems, dessen Kern darin besteht, die Funktion zu minimieren

Gradientenabstiegsmethode. Die in diesem Fall gefundenen Parameter des Modells spiegeln die Position des Modells auf einem bestimmten Bild wider.

Ein Beispiel für die Anpassung eines Modells an ein bestimmtes Bild in 20 Iterationen des Gradientenabstiegs.

Mit AAM können Sie Bilder von Objekten simulieren, die sowohl einer starren als auch einer nicht starren Verformung ausgesetzt sind. AAM besteht aus einer Reihe von Parametern, von denen einige die Form des Gesichts darstellen, der Rest seine Textur. Deformationen werden üblicherweise als geometrische Transformation in Form einer Translations-, Rotations- und Skalierungszusammensetzung verstanden. Bei der Lösung des Problems der Lokalisierung eines Gesichts in einem Bild wird nach AAM-Parametern (Ort, Form, Textur) gesucht, die das synthetisierte Bild darstellen, das dem beobachteten am nächsten kommt. Basierend auf der Nähe von AAM zum angepassten Bild wird entschieden, ob ein Gesicht vorhanden ist oder nicht.

Aktive Formmodelle (ASM)

Das Wesentliche der ASM-Methode besteht darin, die statistischen Beziehungen zwischen der Position anthropometrischer Punkte zu berücksichtigen. Auf dem verfügbaren Beispiel von Bildern von Gesichtern, die in der Vorderansicht aufgenommen wurden. Auf dem Bild markiert der Experte die Position der anthropometrischen Punkte. In jedem Bild sind die Punkte in derselben Reihenfolge nummeriert.

Ein Beispiel für eine Gesichtsformdarstellung mit 68 Punkten

Um die Koordinaten aller Bilder auf ein einziges System zu bringen, wird das sogenannte. Verallgemeinerte Scrolling-Analyse, bei der alle Punkte auf den gleichen Maßstab gebracht und zentriert werden. Ferner werden für den gesamten Satz von Bildern die mittlere Form und die Kovarianzmatrix berechnet. Basierend auf der Kovarianzmatrix werden Eigenvektoren berechnet, die dann in absteigender Reihenfolge ihrer entsprechenden Eigenwerte sortiert werden. Das ASM wird durch eine Matrix Φ und einen mittleren Formvektor s ̅ definiert.

Dann kann jede Form mit einem Modell und Parametern beschrieben werden:

Die Lokalisierung des ASM-Modells auf einem neuen Bild, das nicht im Trainingsbeispiel enthalten ist, wird bei der Lösung des Optimierungsproblems durchgeführt.

A B C D)

Darstellung des Lokalisierungsprozesses des ASM-Modells auf einem bestimmten Bild: a) Anfangsposition b) nach 5 Iterationen c) nach 10 Iterationen d) das Modell konvergierte

Das Hauptziel von AAM und ASM ist jedoch nicht die Gesichtserkennung, sondern die genaue Lokalisierung des Gesichts und der anthropometrischen Punkte im Bild zur weiteren Verarbeitung.

In fast allen Algorithmen ist ein obligatorischer Schritt, der der Klassifizierung vorausgeht, die Ausrichtung, dh die Ausrichtung des Gesichtsbilds an der Frontalposition relativ zur Kamera oder das Bringen eines Satzes von Gesichtern (z. B. in einem Trainingsmuster zum Trainieren eines Klassifizierers) zu einem einzelnen Koordinatensystem. Um dieses Stadium umzusetzen, ist eine Lokalisierung auf dem Bild anthropometrischer Punkte erforderlich, die für alle Gesichter charakteristisch sind - meistens sind dies die Zentren der Pupillen oder die Augenwinkel. Verschiedene Forscher identifizieren verschiedene Gruppen solcher Punkte. Um die Rechenkosten für Echtzeitsysteme zu senken, weisen Entwickler nicht mehr als 10 solcher Punkte zu.

Die AAM- und ASM-Modelle sind so konzipiert, dass diese anthropometrischen Punkte im Gesichtsbild genau lokalisiert werden.

6. Die Hauptprobleme bei der Entwicklung von Gesichtserkennungssystemen

Beleuchtungsproblem

Kopfpositionsproblem (Gesicht ist immerhin ein 3D-Objekt).

Um die Wirksamkeit der vorgeschlagenen Gesichtserkennungsalgorithmen zu bewerten, haben die DARPA-Agentur und das US Army Research Laboratory das FERET-Programm (Face Recognition Technology) entwickelt.

Die groß angelegten Tests des FERET-Programms umfassten Algorithmen, die auf einem flexiblen Vergleich von Graphen und verschiedenen Modifikationen der Hauptkomponentenanalyse (PCA) basierten. Die Effizienz aller Algorithmen war ungefähr gleich. In dieser Hinsicht ist es schwierig oder sogar unmöglich, klar zwischen beiden zu unterscheiden (insbesondere wenn Testtermine vereinbart sind). Für Frontalbilder, die am selben Tag aufgenommen wurden, beträgt die akzeptable Erkennungsgenauigkeit normalerweise 95%. Bei Bildern, die mit verschiedenen Geräten und unter verschiedenen Lichtbedingungen aufgenommen wurden, sinkt die Genauigkeit normalerweise auf 80%. Für Bilder mit einer Differenz von einem Jahr betrug die Erkennungsgenauigkeit ungefähr 50%. Es sollte beachtet werden, dass sogar 50 Prozent mehr als akzeptable Genauigkeit dieser Art von System sind.

FERET veröffentlicht einen Bericht über einen Vergleichstest moderner Gesichtserkennungssysteme, der auf mehr als einer Million Gesichtern pro Jahr basiert. Leider enthüllen die neuesten Berichte nicht die Prinzipien von Gebäudeerkennungssystemen, sondern nur die Ergebnisse des Betriebs kommerzieller Systeme. Das führende System ist heute das von NEC entwickelte NeoFace-System.

Referenzen (beim ersten Link gegoogelt)

1. Bildbasierte Gesichtserkennung - Probleme und Methoden2. Gesichtserkennung Eine Umfrage.pdf

3. Gesichtserkennung Eine Literaturübersicht

4. Eine Übersicht über Gesichtserkennungstechniken

5. Eine Übersicht über Gesichtserkennung, -extraktion und -erkennung

6. Übersicht über Methoden zur Identifizierung von Personen anhand von Gesichtsbildern

7. Methoden zum Erkennen einer Person anhand des Gesichtsbildes

8. Vergleichende Analyse von Gesichtserkennungsalgorithmen

9. Gesichtserkennungstechniken

10. Über einen Ansatz zur Lokalisierung anthropometrischer Punkte.

11. Gesichtserkennung in Gruppenfotos mithilfe von Segmentierungsalgorithmen

12. Forschungsbericht 2. Stufe zur Gesichtserkennung

13. Gesichtserkennung durch Elastic Bunch Graph Matching

14. Algorithmen zur Identifizierung einer Person anhand eines fotografischen Porträts basierend auf geometrischen Transformationen. These.

15. Verzerrungsinvariante Objekterkennung in der Dynamic Link-Architektur

16. Gesichtserkennung mit aktiven Formmodellen, lokalen Patches und Support Vector Machines

17. Gesichtserkennung mit aktiven Darstellungsmodellen

18. Aktive Aussehensmodelle für die Gesichtserkennung

19.Gesichtsausrichtung mit aktivem Formmodell und Support-Vektormaschine

20. Aktive Formmodelle - ihre Ausbildung und Anwendung

21. Fisher Vector Gesichter in freier Wildbahn

22. Eigengesichter vs. Fisherfaces-Erkennung mit klassenspezifischer linearer Projektion

23. Eigengesichter und Fischergesichter

24. Reduzierung der Dimensionalität

25. ICCV 2011 Tutorial zur teilebasierten verformbaren Registrierung

26. Eingeschränktes lokales Modell für die Gesichtsausrichtung, ein Lernprogramm

27. Wer bist du? Lernen von personenbezogenen Klassifikatoren aus Videos

28. Erkennung einer Person durch das Bild eines Gesichts unter Verwendung neuronaler Netzwerkmethoden

29. Gesichtserkennung Ein Faltungsansatz für neuronale Netze

30. Gesichtserkennung mit Convolutional Neural Network und Simple Logistic Classifier

31. Gesichtsbildanalyse mit Faltungs-Neuronalen Netzen

32. Methoden der Gesichtserkennung basierend auf versteckten Markov-Prozessen. Autor-ferat

33. Anwendung von Hidden-Markov-Modellen zur Gesichtserkennung

34. Gesichtserkennung und -erkennung mit Hidden-Markovs-Modellen

35. Gesichtserkennung mit GNU Octave-MATLAB

36. Gesichtserkennung mit Python

37. Anthropometrische 3D-Gesichtserkennung

38.3D Gesichtserkennung

39. Gesichtserkennung basierend auf der Anpassung eines 3D-Morphable-Modells

40. Gesichtserkennung

41. Robuste Gesichtserkennung durch spärliche Darstellung

42. Die FERET-Bewertungsmethode für Gesichtserkennungsalgorithmen

43. Suche nach Gesichtern in elektronischen Sammlungen historischer Fotografien

44. Entwurf, Implementierung und Evaluierung von Hardware-Vision-Systemen für die Gesichtserkennung in Echtzeit

45. Eine Einführung in das Problem der guten, schlechten und hässlichen Gesichtserkennung

46. \u200b\u200bForschung und Entwicklung von Methoden zur Erkennung eines menschlichen Gesichts auf digitalen Bildern. Diplom

47. DeepFace Schließen der Lücke zur Leistung auf menschlicher Ebene bei der Gesichtsüberprüfung

48. Die automatisierte Benennung von Zeichen in TV-Videos entlasten

49. Auf dem Weg zu einem praktischen Gesichtserkennungssystem Robuste Ausrichtung und Beleuchtung durch spärliche Repräsentation

50. Algorithmen zum Erkennen des Gesichts einer Person zur Lösung angewandter Probleme der Bildanalyse und -verarbeitung

51. Gesichtserkennung und Lokalisierung im Bild

52. Modifizierter Viola-Jones Mod

53. Entwicklung und Analyse von Algorithmen zur Erkennung und Klassifizierung von Objekten auf der Grundlage maschineller Lernmethoden

54. Überblick über die große Herausforderung der Gesichtserkennung

55. Face Recognition Vendor Test (FRVT)

56. Zur Effizienz der Verwendung des SURF-Algorithmus beim Problem der Identifizierung von Gesichtern

Vielleicht gibt es heute keine andere Technologie, um die es so viele Mythen, Lügen und Inkompetenzen geben würde. Die Journalisten, die über Technologie sprechen, lügen, die Politiker, die über erfolgreiche Implementierung sprechen, lügen, die Mehrheit der Technologieverkäufer lügt. Jeden Monat sehe ich die Konsequenzen von Menschen, die versuchen, die Gesichtserkennung in Systeme zu implementieren, die nicht damit arbeiten können.

Das Thema dieses Artikels war lange Zeit schmerzhaft, aber ich war irgendwie zu faul, um es zu schreiben. Viel Text, den ich schon zwanzig Mal für verschiedene Leute wiederholt habe. Aber nachdem ich eine weitere Packung Müll gelesen hatte, entschied ich, dass es Zeit war. Ich werde einen Link zu diesem Artikel geben.

So. In diesem Artikel werde ich einige einfache Fragen beantworten:

Woher haben Ihrer Meinung nach die Entwickler der Algorithmen diese Grundlagen?

Ein kleiner Tipp. Das erste NTech-Produkt, das sie jetzt sind, ist Find Face, eine Suche nach Personen durch Kontakt. Ich denke, es sind keine Erklärungen erforderlich. Natürlich kämpft VKontakte gegen Bots, die alle offenen Profile herunterladen. Aber soweit ich gehört habe, pumpen die Leute immer noch. Und Klassenkameraden. Und instagram.

Wie bei Facebook - dort ist es komplizierter. Aber ich bin mir ziemlich sicher, dass sie sich auch etwas ausgedacht haben.

Also ja, wenn dein Profil offen ist, dann kannst du stolz sein, es wurde verwendet, um Algorithmen zu trainieren;)

Über Lösungen und über Unternehmen

Hier können Sie stolz sein. Von den 5 führenden Unternehmen der Welt sind jetzt zwei Russen. Dies sind N-Tech und VisionLabs. Vor einem halben Jahr waren NTech und Vocord die Anführer, der erstere arbeitete viel besser bei gedrehten Gesichtern, der zweite bei frontalen.Jetzt sind die anderen Führer 1-2 chinesische Unternehmen und 1 Amerikaner, Vocord hat etwas in den Ratings bestanden.

Auch russisch in der Bewertung von itmo, 3divi, Intellivision. Synesis ist eine belarussische Firma, obwohl einige einmal in Moskau waren, hatten sie vor ungefähr 3 Jahren einen Blog über Habré. Ich kenne auch einige Lösungen, die ausländischen Unternehmen gehören, aber die Entwicklungsbüros befinden sich auch in Russland. Es gibt auch mehrere russische Unternehmen, die nicht im Wettbewerb stehen, aber gute Lösungen zu haben scheinen. Zum Beispiel haben die MDGs. Natürlich haben Odnoklassniki und Vkontakte auch ihre eigenen guten, aber sie sind für den internen Gebrauch.

Kurz gesagt, ja, meistens sind wir und die Chinesen auf unseren Gesichtern verschoben.

Im Allgemeinen war NTech der erste auf der Welt, der gute Parameter auf einem neuen Niveau zeigte. Irgendwann Ende 2015. VisionLabs holte nur NTech ein. 2015 waren sie Marktführer. Aber ihre Entscheidung war von der letzten Generation und sie begannen erst Ende 2016 zu versuchen, NTech einzuholen.

Um ehrlich zu sein, mag ich diese beiden Unternehmen nicht. Sehr aggressives Marketing. Ich habe Leute gesehen, denen eine eindeutig unangemessene Lösung gegeben wurde, die ihre Probleme nicht löste.

Auf dieser Seite mochte ich Vocord viel mehr. Ich habe einmal die Leute konsultiert, denen Vocord sehr ehrlich gesagt hat: "Ihr Projekt wird mit solchen Kameras und Installationspunkten nicht funktionieren." NTech und VisionLabs versuchten glücklich zu verkaufen. Aber etwas Vocord ist kürzlich verschwunden.

Schlussfolgerungen

In den Schlussfolgerungen möchte ich Folgendes sagen. Die Gesichtserkennung ist ein sehr gutes und leistungsstarkes Werkzeug. Es erlaubt Ihnen wirklich, heute Kriminelle zu finden. Die Implementierung erfordert jedoch eine sehr genaue Analyse aller Parameter. Es gibt genügend OpenSource-Lösungen, bei denen. Es gibt Anwendungen (Anerkennung in Stadien in einer Menschenmenge), bei denen nur VisionLabs | Ntech installiert werden muss und ein Team aus Wartung, Analyse und Entscheidungsfindung vorhanden ist. Und OpenSource hilft Ihnen hier nicht weiter.Heute kann man nicht allen Geschichten glauben, dass man alle Kriminellen fangen oder jeden in der Stadt beobachten kann. Aber es ist wichtig, sich daran zu erinnern, dass solche Dinge helfen können, Kriminelle zu fangen. Zum Beispiel, um nicht alle in der U-Bahn anzuhalten, sondern nur diejenigen, die das System als ähnlich ansieht. Platzieren Sie Kameras so, dass Gesichter besser erkannt werden, und schaffen Sie dafür eine geeignete Infrastruktur. Obwohl ich zum Beispiel dagegen bin. Für die Kosten des Fehlers kann es zu hoch sein, wenn Sie als jemand anderes erkannt werden.

Tags hinzufügen