8800 GTX стало эпохальным событием в истории 3D-графики. Это была первая карта с поддержкой DirectX 10 и связанной с ним единой модели шейдера, что значительно повысило качество изображения по сравнению с предыдущими поколениями, и в плане производительности она долго оставалась без конкурентов. К сожалению, вся эта мощь и стоила соответственно. Учитывая ожидаемую конкуренцию со стороны ATI и выпуск более дешевых моделей среднего уровня на основе той же технологии, GTX считалась картой, ориентированной лишь на тех энтузиастов, которые хотели быть на переднем крае современных достижений в области обработки графики.

История модели

Чтобы исправить эту ситуацию, компания nVidia через месяц выпустила карту той же линейки GTS 640MB, а еще через пару месяцев - GTS 320MB. Обе предлагали близкую к GTX производительность, но по гораздо более разумной цене. Однако при стоимости около 300-350 долларов они все еще были слишком дорогими для геймеров с ограниченным бюджетом - это были модели не среднего, а высокого класса. Оглядываясь назад, можно сказать, что GTS стоили каждого вложенного в них цента, поскольку то, что последовало за ними в течение оставшейся части 2007 года, вызывало одно разочарование вслед за другим.

Первыми появились карты предполагаемого среднего ценового диапазона 8600 GTS и GT, представлявшие собой сильно урезанные версии серии 8800. Они были меньше и тише и имели новые возможности обработки HD-видео, но их производительность оказалась ниже ожидаемого уровня. Приобретение их было нецелесообразным, хотя стоили они относительно недорого. Альтернативная видеокарта ATI Radeon HD 2900 XT соответствовала GTS 640MB в плане быстродействия, но под нагрузкой потребляла огромное количество энергии и была слишком дорогой, чтобы относиться к среднему диапазону. Наконец, компания ATI попыталась выпустить серию DX10 в форме HD 2600 ХТ и Pro, мультимедийные возможности которых были даже лучше, чем у nVidia 8600, но им не хватило мощности, чтобы стать достойными внимания геймеров, уже купивших видеокарты предыдущего поколения, такие как X1950 Pro или 7900 GS.

И вот спустя год после начала продаж 8800 GTX c выпуском 8800 GT появилось первое настоящее обновление модели с поддержкой DirectX 10. Хотя для этого потребовалось много времени, но у nVidia GeForce 8800 GT характеристики соответствовали модели GTS, а стоимость - в пределах 200-250 долларов, наконец, достигла того среднего ценового диапазона, которого все так долго ждали. Но что сделало карту такой особенной?

Больше - не значит лучше

По мере развития технологий и числа транзисторов в ЦПУ и ГПУ возникает естественная необходимость в уменьшении их размеров. Это ведет к снижению энергопотребления, что, в свою очередь, означает, меньший нагрев. На одном кристалле кремния умещается больше процессоров, что снижает их себестоимость и теоретически дает нижний предел цены на изготовленное из них оборудование. Однако изменение производственных процессов представляет высокие риски для бизнеса, поэтому принято выпускать абсолютно новую архитектуру на уже существующих и опробованных технологиях, как это было в случае с 8800 GTX и HD 2900 ХТ. С усовершенствованием архитектуры происходит переход на менее энергоемкое аппаратное обеспечение, на котором позже снова базируется новый дизайн.

По этому пути следовала серия 8800 с ядрами G80 у GTX и GTS, производимыми по 90-нм технологии, а nVidia GeForce 8800 GT основана на чипе G92, сделанном уже с использованием 65-нм процесса. Хотя изменение кажется не очень большим, оно равнозначно 34% сокращению размера подложки или 34% увеличению числа процессоров на кремниевой пластине. В итоге электронные компоненты становятся меньше, дешевле, более экономичными, что является исключительно положительным изменением. Впрочем, ядро G92 не просто уменьшилось, есть еще кое-что.

Прежде всего, движок обработки видео VP2, который использовался в серии 8600, теперь появился в GeForce 8800 GT 512MB. Так что теперь есть возможность наслаждаться видео высокой четкости без торможения системы. Окончательный движок дисплея, который управляется отдельным чипом на 8800 GTX также интегрирован в G92. В результате на кристалле стало на 73 миллиона транзисторов больше, чем у 8800 GTX (754 млн против 681 млн), хотя количество потоковых процессоров, мощностей для обработки текстуры и ROP стало меньше, чем у более мощной модели.

Новая версия алгоритма прозрачного сглаживания nVidia, добавленная в арсенал GeForce 8800 GT, призвана значительно улучшить качество изображения, сохраняя высокую производительность системы. Помимо этого, новых графических возможностей новый процессор не прибавил.

Компания-производитель, видимо, долго размышляла над тем, какой именно функционал предыдущих карт серии 8800 не использовался в полной мере и мог быть сокращен, а какой следовало оставить. Результатом стал дизайн графического процессора, который, с точки зрения показателей работы, расположился где-то между GTX и GTS, но с функционалом GTS. В итоге карта 8800 GTS стала совершенно излишней. 8800 Ultra и GTX по-прежнему обеспечивают более высокую графическую мощность, но с меньшим количеством функций, по гораздо большей цене и с высоким энергопотреблением. На этом фоне карта GeForce 8800 GT 512 МБ действительно заняла сильные позиции.

Архитектура графического процессора

В видеокарте GeForce 8800 GT использована та же унифицированная архитектура, которую компания nVidia представила, когда впервые сообщила о выпуске процессора G80. G92 состоит из 754 млн транзисторов и изготовлен по 65-нм процессу TSMC. Размер подложки составляет около 330 мм 2 , и хотя это заметно меньше, чем у G80, еще далеко до того, чтобы называться маленьким кусочком кремния. В общей сложности имеется 112 ядер скалярного потока, которые в стандартной конфигурации работают на частоте 1500 МГц. Они сгруппированы в 7 кластеров, каждый из которых имеет 16 потоковых процессоров, которые делят 8 адресных блоков текстур, 8 секций текстурных фильтров и собственный независимый кэш. Это такая же конфигурация, которую nVidia использовала в чипах G84 и G86 на уровне шейдерных кластеров, но G92 - гораздо более сложное ГПУ, чем любой из них.

Каждый из шейдерных процессоров за один такт может формировать две команды MADD и MUL, объединенные в единую структуру блоки могут обрабатывать все шейдерные операции и расчеты, которые поступают как в целочисленной, так и в форме с плавающей запятой. Любопытно, однако, что, несмотря на возможности потоковых процессоров быть такими же, как G80 (кроме количества и частоты), nVidia утверждает, что чип может совершать до 336 GFLOPS. Однако для вычисления NADD и MUL требуется скорость 504 GFLOPS. Как оказалось, компания-производитель использовала консервативный подход к определению вычислительной мощности и в расчете общей производительности не учла MUL. На брифингах и круглых столах представители nVidia рассказали, что некоторые архитектурные усовершенствования должны позволить чипу приблизиться к его теоретически максимальной пропускной способности. В частности, был улучшен диспетчер задач, распределяющий и уравновешивающий данные, которые поступают по конвейеру. NVidia объявила, что будет поддерживать двойную точность будущих графических процессоров, но данный чип ее лишь эмулирует, что связано с необходимостью следовать стандартам IEEE.

Архитектура ROP

Структура ROP у G92 похожа на строение любого другого графического процессора семейства GeForce восьмой серии. Это значит, что каждая секция имеет кэш второго уровня и назначена к 64-битному каналу памяти. В общей сложности есть 4 секции ROP и 256-битный интерфейс хранилища данных. Каждая из них способна обрабатывать 4 пикселя за такт, если каждый из них задан четырьмя параметрами (цветом RGB и Z). Если представлен только Z-компонент, то каждая секция может обрабатывать 32 пикселя за такт.

ROP поддерживают все распространенные форматы сглаживания, использовавшиеся в ГПУ предыдущих моделей восьмой серии GeForce. Так как чип имеет 256-битный интерфейс GDDR, nVidia решила сделать некоторые улучшения в эффективности сжатия ROP, чтобы сократить использование полосы пропускания и графической памяти при включенном сглаживании в разрешениях 1600х1200 и 1920х1200.

Как производная от оригинальной архитектуры G80, блоки фильтров и адресов текстур, а также секции ROP работают на тактовой частоте, отличной от частоты потоковых процессоров. Компания nVidia называет это основной скоростью. В случае GeForce 8800 GT характеристики видеокарты определяются частотой 600 МГц. Теоретически это приводит к скорости заполнения 9600 гигапикселей в секунду (Гп/с) и билинейной скорости закраски текстур 33,6 Гп/с. По мнению пользователей, тактовая частота очень занижена, а рост числа транзисторов не гарантирует добавления или сохранения функциональных возможностей. Когда компания перешла со 110-нм на 90-нм технологию, благодаря оптимизации она снизила число транзисторов на 10%. Поэтому будет неудивительно, если на чипе окажется еще как минимум 16 потоковых процессоров, отключенных в данном продукте.

Конструктивное исполнение

Эталонный дизайн карты предусматривает работу ядра, блока шейдеров и памяти на частоте 600 МГц, 1500 МГц и 1800 МГц соответственно. 8800 GT отличается однослотовой системой охлаждения, а глянцевый черный металлический кожух почти полностью скрывает ее лицевую сторону. Вентилятор диаметром 50 мм соответствует конструкции радиальных кулеров топ-моделей и выполняет свои обязанности очень тихо во всех режимах работы. Неважно, работает ли компьютер вхолостую, загруженный лишь рабочим столом Windows, или запущена любимая игра - его практически не будет слышно на фоне других источников шума в корпусе ПК. Однако стоит отметить, что при первом включении компьютера с новой видеокартой можно испугаться. Вентилятор начинает завывать, когда графический процессор загружен на полную мощность, но шум стихает еще до появления рабочего стола.

Металлическая лицевая панель притягивает отпечатки пальцев, но это мало должно волновать, так как после установки увидеть их будет невозможно. По отзывам пользователей, крышка помогает предотвратить случайное повреждение компонентов, таких как конденсаторы, на лицевой стороне карты. Печатная плата, окрашенная в зеленый цвет, в сочетании с черной лицевой панелью радиатора, обеспечивает 8800 GT узнаваемость. Модель маркирована логотипом GeForce вдоль верхнего края лицевой панели. Марк Рейн, вице-президент компании, сказал журналистам, что это повлекло дополнительные расходы, но было необходимо, чтобы помочь пользователям разобраться, какая видеокарта является сердцем системы на LAN-вечеринках.

Под радиатором скрываются восемь 512-мегабитных чипов графической памяти, что в общей сложности дает 512 МБ объема хранилища данных. Это GDDR3 DRAM с эффективной частотой до 2000 МГц. Графический процессор поддерживает как GDDR3, так и GDDR4, но в данной серии эта возможность так и не была использована.

Нагрев и потребляемая мощность

Видеокарта nVidia GeForce 8800 GT очень сексапильна. Ее дизайн просто очень приятен для глаз и, с учетом внутренних изменений в G92, от нее исходит ощущение выдержанного дизайна.

Более важным, чем эстетические аспекты, однако, по мнению пользователей является факт, что производителю удалось вместить всю мощь в однослотовое устройство. Это не просто желанное изменение, оно приятно удивляет. У GeForce 8800 GT характеристики таковы, что можно предположить наличие кулера высотой в два слота. Причиной того, почему nVidia обошлась таким тонким дизайном, стали изменения в процессе производства, которые позволили снизить нагрев до уровня, с которым смог справиться низкопрофильный вентилятор. На самом деле температурный режим снизился настолько, что даже сравнительно небольшой кулер не должен вращаться очень быстро, в результате чего карта остается практически бесшумной даже во время обработки интенсивных игр. Однако температура платы значительно повышается, поэтому требуется значительное количество воздуха для предотвращения перегрева. В результате уменьшения технологического процесса GeForce 8800 GT 512 MB потребляет лишь 105 Вт даже при полной нагрузке. Таким образом, требуется только один шестиконтактный разъем питания. Это еще одно приятное изменение.

Карта первая стала поддерживать PCIe 2.0, позволяющий получать мощность до 150 Вт. Однако в компании посчитали, что для обратной совместимости гораздо проще ограничить питание через него 75 ваттами. Это значит, что независимо от того, подключена карта к материнским платам с PCIe 1.1 или PCIe 2.0, через разъем поступает лишь 75 Вт, а остальная энергия поступает через дополнительный разъем.

Процессор VP2

Говоря о возможности передачи сигналов HDCP, стоит коснуться видеопроцессора нового поколения, который компания nVidia инкорпорировала в G92. VP2 является единым программируемым SIMD-процессором, гибкость которого позволяет ему расширяться в будущем. Он обеспечивает очень интенсивную обработку видео, кодированного в H.264, перекладывая нагрузку с ЦПУ на ГПУ. В дополнение к VP2 есть также потоковый процессор H.264 и дешифратор AES128. Первый из них специально разработан для ускорения схем кодирования CAVLC и CABAC - задач, которые очень загружают центральный процессор в чисто программной среде. AES128 позволяет быстрее обрабатывать протокол шифрования, необходимый для таких схем безопасности видеоконтента, как AACS и Media Foundation. Обе эти схемы требуют кодирования видеоданных (как сжатых, так и несжатых) при передаче по шинам, подобным PCI-Express.

Улучшение качества изображения

Компания nVidia упорно пытается улучшить технику прозрачного сглаживания, которая впервые появилась в 7-ой серии GeForce. Мультисэмплинг мало снижает производительность карты, но в большинстве случаев не является эффективным. С другой стороны, суперсэиплинг обеспечивает намного лучшее и более стабильное качество изображения, но за счет снижения скорости работы -- это невероятно ресурсоемкий способ сглаживания.

Драйвера, которые поставляются вместе с видеокартой, содержат новый алгоритм мультисэмплинга. Различия довольно значительные, но окончательное решение принимает сам пользователь. Хорошая новость заключается в том, что так как это изменение на уровне драйвера, то любое оборудование, которое поддерживает прозрачное сглаживание, может использовать новый алгоритм, в том числе карты, выпущенные после GeForce 7800 GTX. Чтобы активировать новый режим, нужно просто скачать последние обновления на сайте производителя.

По отзывам пользователей, для GeForce 8800 GT драйвер обновить труда не составит. Хотя веб-страница видеокарты содержит лишь ссылки на файлы для ОС Windows Vista и XP, поиск с главной страницы позволяет найти необходимое. Для nVidia GeForce 8800 GT драйвера Windows 7-10 устанавливаются утилитой GeForce 342.01 Driver объемом 292 МБ.

Возможности подключения

Выходные разъемы у nVidia GeForce 8800 GT вполне стандартные - 2 двухканальных DVI-I-порта с поддержкой HDCP, которые подходят как для аналоговых, так и цифровых интерфейсов мониторов и телевизоров, а 7-контактный аналоговый видеопорт обеспечивает обычный композитный и компонентный выход. Разъемы DVI можно использовать в сочетании с переходником DVI-VGA и DVI-HDMI, так что возможен любой вариант подключения. Тем не менее nVidia по-прежнему делает поддержку аудио для использования с разъемами HDMI опциональным вариантом для сторонних производителей - внутри VP2 аудиопроцессор отсутствует, поэтому звук реализуется через разъем S/PDIF на плате. Это разочаровывает, так как тонкая и тихая карта идеально подходит для игровых домашних кинотеатров.

GeForce 8800 GT является первой графической системой, совместимой с PCI Express 2.0, что означает возможность обращения к памяти со скоростью 16 ГБ/с. - в два раза быстрее предыдущего стандарта. Хотя это может быть полезным для рабочих станций и выполнения интенсивных вычислений, рядовому геймеру это не пригодится. В любом случае стандарт полностью совместим со всеми предыдущими версиями PCIe, поэтому беспокоиться не о чем.

Компании-партнеры nVidia предлагают разогнанные версии GeForce 8800 GT, а также пакеты с играми.

BioShock от 2К Games

BioShock являлась одной из лучших игр, существовавших на момент выпуска видеокарты. Это «генетически модифицированный» шутер от первого лица, события которого разворачиваются в подводном городе Rapture, созданном на дне Атлантического океана человеком по имени Эндрю Райан как часть реализации его мечты в стиле арт-деко 1930 годов. 2К Boston и 2K Australia лицензировали и использовали Unreal Engine 3 компании Epic Games, чтобы добиться лучшего эффекта, а также применили некоторые возможности DirectX 10. Все это управляется через опцию на панели управления графикой игры.

Место действия BioShock вынудило разработчиков использовать много шейдеров воды. Технология DirectX 10 помогла улучшить рябь при движении персонажей по воде, а для создания мокрых объектов и поверхностей массово использовались пиксельные шейдеры. Кроме того, DX10-версия игры использует буфер глубины для создания «мягких» эффектов частиц, при которых они взаимодействуют со своим окружением и выглядят более реалистично.

nVidia GeForce 8800 GT, характеристики которой позволяют ей в игре BioShock проявить себя с сильной стороны, на разрешении 1680x1050 лишь немного уступает GTX. При увеличении этого параметра разрыв между картами увеличивается, но не с большим отрывом. Причиной этого, вероятно, является тот факт, что игра не поддерживала прозрачное сглаживание, и массивное преимущество 8800 GTX в пропускной способности памяти становится спорным.

По отзывам пользователей, 8800 GT также достаточно хорошо работает со включенным SLI. Хотя ее возможности и близко не соответствуют GTX, видеокарте Radeon HD 2900 ХТ с объемом памяти 512 МБ в конфигурации CrossFire конкуренцию она составляет. Наверное, еще более интересным является факт, что на разрешении 1920х1200 видеокарта 8800 GT почти так же быстра, как GTS 640 МБ!

Crysis Syngle Player Demo от Electronic Arts

Эта игра заставит видеокарту плакать в буквальном смысле! Большим сюрпризом стала ее графика - она превзошла все, что было в компьютерных играх до нее. Тестирование с помощью встроенного определителя быстродействия графического процессора проходит намного быстрее, чем в действительности. Около 25 к/с в тесте производительности достаточно, чтобы получить приемлемую для пользователя частоту кадров. В отличие от других игр низкий фреймрейт здесь по-прежнему выглядит довольно ровно.

Видеокарта nVidia GeForce 8800 GT, характеристики которой в Crysis позволяют добиться достаточной частоты кадров на разрешении 1680x1050 с высокой детализацией под DirectX 10, не так быстра, как GTX, но заметно производительнее Radeon HD 2900 ХТ и 8800 GTS 640MB. GTS 320MB с трудом справляется с Crysis и потребуется снизить большинство настроек до средних, чтобы получить фреймрейт выше 25 к/с даже при качестве изображения 1280 х 1024 точек.

Производительность

Как и следовало ожидать, 8800 GTX осталась непревзойденной, но в целом GeForce 8800 GT GTS опережает в большинстве тестов. На самых высоких разрешениях и установках сглаживания сниженная пропускная способность памяти GT подводит и GTS время от времени вырывается вперед. Однако учитывая разницу в цене и другие преимущества, 8800 GT лучше в любом случае. И наоборот, сравнение GeForce GTX 8800/GT 8800 каждый раз подтверждает, почему первая карта стоит так дорого. В то время как другие модели начинают существенно тормозить с ростом количества точек изображения, с применением прозрачного сглаживания и анизотропной фильтрации, 8800 GTX продолжает демонстрировать отличные результаты. В частности, Team Fortress 2 при разрешении 1920x1200 с 8хАА и 16xAF на 8800 GTX идет вдвое быстрее, чем на GT. Однако по большей части видеокарта GeForce 8800 GT показывает хорошую производительность. Конечно, если не принимать во внимание невероятно низкую частоту кадров в Crysis.

Заключение

Хотя характеристики видеокарты GeForce 8800 GT и не превзошли спецификации лидера серии 8800 GTX, она обеспечивает близкую производительность за малую долю цены, а также включает много дополнительных возможностей. А если сюда добавить небольшие размеры и тихую работу, то модель покажется просто феноменальной.

Обновление: мы решили дополнить первоначальный обзор дополнительными теоретическими сведениями, сравнительными таблицами, а также результатами тестов американской лаборатории THG, где участвовала и "младшая" карта GeForce 8800 GTS. В обновлённой статье вы также найдёте тесты качества.

GeForce 8800 GTX - на голову выше конкурентов.

Вы наверняка слышали о DirectX 10 и чудесах, которые новый API обещает по сравнению с DX9. В Интернете можно найти скриншоты игр, которые всё ещё находятся в разработке. Но до сего момента видеокарт с поддержкой DX10 на рынке не было. И nVidia исправила этот недостаток первой. Поприветствуем выход видеокарт DirectX 10 в виде nVidia GeForce 8800 GTX и 8800 GTS!

Единая унифицированная архитектура сможет больше выжать из блоков шейдеров, поскольку их теперь можно использовать эффективнее, чем при фиксированной раскладке. Новую эру в компьютерной графике открывают GeForce 8800 GTX со 128 унифицированными блоками шейдеров и GeForce 8800 GTS с 96 такими блоками. Наконец-то прошли дни пиксельных конвейеров. Но давайте внимательнее посмотрим на новые карты.

На подложке показаны 80 графических ядер. Новый графический процессор обещает дать в два раза более высокую производительность, чем GeForce 7900 GTX (G71). 681 миллион транзисторов приводит к огромной площади кристалла, но когда мы спросили об этом, то CEO nVidia Джен-Хсун Хуан (Jen-Hsun Huang) ответил: "Если бы мои инженеры сказали, что могут удвоить производительность, удвоив площадь кристалла, я бы даже не сомневался!"

Как показывает опыт, удвоение площади отнюдь не удваивает производительность, но nVidia, похоже, нашла правильный баланс между технологическими продвижениями и реализацией кристалла на кремнии.

GeForce 8800 GTX и 8800 GTS полностью соответствуют стандарту DX10 и Shader Model 4.0, различным стандартам хранения и передачи данных, поддерживают геометрические шейдеры и потоковый вывод (Stream Out). Как же всё это реализовала nVidia?

Начнём с того, что nVidia отошла от фиксированного дизайна, который последние 20 лет использует индустрия, в пользу унифицированного шейдерного ядра.

Раньше мы демонстрировали схожие слайды, иллюстрирующие тенденцию увеличения мощности пиксельных шейдеров. nVidia прекрасно знает об этой тенденции и движется в сторону балансировки вычислительных потребностей, реализуя унифицированные шейдеры, через которые проходят потоки данных. Это даёт максимальную эффективность и производительность.

nVidia утверждает: "Команда разработчиков GeForce 8800 прекрасно понимала, что high-end 3D-игры DirectX 10 потребуют большой аппаратной мощности для расчёта шейдеров. Хотя DirectX 10 оговаривает унифицированный набор инструкций, стандарт не требует унифицированного дизайна шейдеров GPU. Но инженеры GeForce 8800 верили, что именно унифицированная шейдерная архитектура GPU позволит эффективно распределить нагрузку программ-шейдеров DirectX 10, улучшая архитектурную эффективность GPU и правильно распределяя доступную мощность".

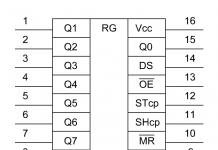

GeForce 8800 GTX | 128 потоковых процессоров SIMD

|

Процессорное ядро работает на частоте 575 МГц у GeForce 8800 GTX и на 500 МГц - у GeForce 8800 GTS. Если остальная часть ядра работает на 575 МГц (или 500 МГц), то ядро шейдеров использует собственный тактовый генератор. У GeForce 8800 GTX оно работает на 1350 ГГц, а у 8800 GTS - на 1200 ГГц.

Каждый шейдерный элемент ядра называется потоковым процессором (Streaming Processor). У GeForce 8800 GTX используется 16 блоков по восемь таких элементов. В результате мы и получаем 128 потоковых процессоров. Подобно дизайну ATi R580 и R580+, где присутствуют блоки пиксельных шейдеров, nVidia планирует в будущем как добавлять, так и убирать блоки. Собственно, это мы и наблюдаем с 96 потоковыми процессорами в GeForce 8800 GTS.

|

Нажмите на картинку для увеличения.

GeForce 8800 GTX | сравнительная таблица спецификаций

nVidia раньше не могла одновременно выполнять полноэкранное сглаживание с HDR-освещением, но это уже история. Каждый блок растровых операций (ROP) поддерживает смешение кадрового буфера. Таким образом, со сглаживанием мультисэмплинга могут использоваться цели рендеринга как FP16, так и FP32. Под D3D10 ускорения обработки цветов и Z в блоках растровых операций могут использоваться до восьми множественных целей рендеринга, а также новые технологии сжатия.

GeForce 8800 GTX может заполнять 64 текстуры за такт, а при частоте 575 МГц мы получаем 36,8 млрд. текстур за секунду (GeForce 8800 GTS = 32 млрд./с). GeForce 8800 GTX обладает 24 блоками растровых операций (ROP) и при работе карты на частоте 575 МГц пиковая пиксельная скорость заполнения составляет 13,8 гигапикселя/с. Версия GeForce 880GTS обладает 20 ROP и даёт пиковую скорость заполнения 10 гигапикселей/с на частоте 500 МГц.

| Спецификации nVidia GeForce | ||||||

| 8800GTX | 8800GTS | 7950GX2 | 7900GTX | 7800GTX 512 | 7800GTX | |

| Техпроцесс (нм) | 90 | 90 | 90 | 90 | 110 | 110 |

| Ядро | G80 | G80 | G71 | G71 | G70 | G70 |

| Число GPU | 1 | 1 | 2 | 1 | 1 | 1 |

| Число транзисторов на ядро (млн.) | 681 | 681 | 278 | 278 | 302 | 302 |

| Частота вершинных блоков (МГц) | 1350 | 1200 | 500 | 700 | 550 | 470 |

| Частота ядра (МГц) | 575 | 500 | 500 | 650 | 550 | 430 |

| Частота памяти (МГц) | 900 | 600 | 600 | 800 | 850 | 600 |

| Эффективная частота памяти (МГц) | 1800 | 1200 | 1200 | 1600 | 1700 | 1200 |

| Число вершинных блоков | 128 | 96 | 16 | 8 | 8 | 8 |

| Число пиксельных блоков | 128 | 96 | 48 | 24 | 24 | 24 |

| Число ROP | 24 | 20 | 32 | 16 | 16 | 16 |

| Ширина шины памяти (бит) | 384 | 320 | 256 | 256 | 256 | 256 |

| Объём памяти на GPU (Мбайт) | 768 | 640 | 512 | 512 | 512 | 256 |

| Пропускная способность памяти на GPU (Гбайт/с) | 86,4 | 48 | 38,4 | 51,2 | 54,4 | 38,4 |

| Число вершин/с (млн.) | 10 800 | 7200 | 2000 | 1400 | 1100 | 940 |

| Пиксельная пропускная способность (число ROP x частоту, в млрд./с) | 13,8 | 10 | 16 | 10,4 | 8,8 | 6,88 |

| Текстурная пропускная способность (число пикс. конвейеров x частоту, в млрд./с) | 36,8 | 32 | 24 | 15,6 | 13,2 | 10,32 |

| RAMDAC (МГц) | 400 | 400 | 400 | 400 | 400 | 400 |

| Шина | PCI Express | PCI Express | PCI Express | PCI Express | PCI Express | PCI Express |

Обратите внимание на ширину шины памяти. Если взглянуть на схему, приведённую на предыдущей странице, у GPU GeForce 8800 GTX используются шесть разделов памяти. Каждый из них оснащён 64-битным интерфейсом к памяти, что даёт в сумме ширину 384 бита. 768 Мбайт памяти GDDR3 подключёны к подсистеме памяти, которая построена на высокоскоростном кросс-коммутаторе, как у GPU GeForce 7x. Этот кросс-коммутатор поддерживает память DDR1, DDR2, DDR3, GDDR3 и GDDR4.

GeForce 8800 GTX использует память GDDR3 с частотой по умолчанию 900 МГц (версия GTS работает на 800 МГц). С шириной 384 бита (48 байт) и частотой 900 МГц (1800 МГц эффективная частота DDR) пропускная способность составляет целых 86,4 Гбайт/с. А 768 Мбайт памяти позволяют хранить намного более сложные модели и текстуры, с более высоким разрешением и качеством.

GeForce 8800 GTX | nVidia отправляет ATi в нокаут

Нажмите на картинку для увеличения.

У нас есть хорошие и плохие новости. Хорошие - быстрее быстрого, они очень тихие и в них столько интересных технических штучек, для которых даже ещё нет софта. Плохая новость - их нет в продаже. Ну да, с новым "железом" всегда что-то не так. Sparkle продаёт такие карты по 635 евро. К подобным ценам на топовое "железо" мы уже начинаем привыкать.

Плата в длину составляет 27 сантиметров, поэтому установить её вы сможете далеко не в каждый корпус. Если в вашем компьютере жёсткие диски расположены прямо за слотами PCIe, то, скорее всего, установка GeForce 8800 GTX будет непростым делом. Конечно, диски всегда можно передвинуть в 5-дюймовый отсек через переходник, но согласитесь, в самой проблеме приятного мало.

Нажмите на картинку для увеличения.

Над технической реализацией не стоит смеяться. это лучший кусок "железа", который вы можете купить в подарок своему ПК на Новый год. Почему GeForce 8800 GTX вызвала столько внимания к себе среди интернет-общественности? Элементарно - дело в рекордных показателях производительности. Так, в Half-Life 2: Episode 1 количество кадров в секунду на GeForce 8800 GTX в разрешении 1600x1200 на целых 60 процентов выше, чем у топовых семейства Radeon X1000 (1900 XTX и X1950 XTX).

Oblivion на всех уровнях идёт запредельно плавно. Если точнее, то с включённым HDR-рендерингом в Oblivion скорость составляет не менее 30 fps. В игре Titan Quest не получается увидеть менее 55 кадров в секунду. Иногда задумываешься, не повис ли бенчмарк, или может с уровнями что-то произошло. Включение полноэкранного сглаживания и анизотропной фильтрации вообще никак не сказывается на GeForce 8800.

Это самая быстрая видеокарта среди всех моделей, выпущенных в 2006 году. Только Radeon X1950 XTX в парном режиме CrossFire кое-где догоняет 8800 GTX. Так что если вы спрашивали, на какой же карте Gothic 3, Dark Messiah и Oblivion не тормозят, то вот он ответ - перед вами GeForce 8800 GTX.

GeForce 8800 GTX | Два гнезда питания

Питание к поступает аж через два гнезда сверху платы. Оба необходимы - если вынуть кабель из левого, то 3D-производительность здорово снизится. Хотите, чтобы соседи сошли с ума? Тогда выньте правый - безумному писку, что начнёт раздаваться из платы, позавидует сигнализация вашего автомобиля. Сама плата при этом вообще не включится. Отметим, что nVidia рекомендует использовать с GeForce 8800 GTX блок питания мощностью не менее 450 ватт, и чтобы на линии 12 вольт могло быть 30 ампер.

На GeForce 8800 GTX подключены должны быть оба гнезда питания. Нажмите на картинку для увеличения.

Два гнезда питания объясняются просто. Согласно спецификациям PCI Express, на один слот PCIe может приходиться не более 75 Ватт энергии. Наш тестовый только в режиме 2D потребляет порядка 180 Ватт. Это на целых 40 Ватт больше, чем у Radeon X1900 XTX или X1950 XTX. Ну, а в режиме 3D плата "кушает" порядка 309 Ватт. Те же Radeon X1900/1950 XTX в этом случае потребляют от 285 до 315 Ватт. На какие нужды GeForce 8800 пускает столько энергии при работе в простом Windows, нам непонятно.

Ещё два разъёма зарезервированы под режим SLI. Согласно документации nVidia, для SLI требуется всего один штекер. Второй пока не используется. Теоретически, имея два разъёма, можно связать в многоплатную систему более двух . Появление второго разъёма можно увязать и с прогрессирующей популярностью аппаратного расчета физики. Может быть, через него будет подключаться ещё одна видеокарта, чтобы считать именно физические функции в движке игры. А может быть, речь идёт о Quad SLI на 4 платах, или о чём-то вроде того.

Для SLI теперь зарезервирован дополнительный разъём. Но с текущей версией драйвера воспользоваться можно лишь одним. Нажмите на картинку для увеличения.

GeForce 8800 GTX | Тихая система охлаждения

GeForce 8800 оснащена очень тихим 80-миллиметровым кулером-турбиной. Как и у Radeon X1950 XTX, он расположен в самом конце платы, чтобы прогонять прохладный воздух через всю поверхность GeForce 8800 и затем наружу. В конце платы установлена специальная решётка, которая выпускает горячий воздух не только наружу, через отверстие, занимающее второй слот, но и вниз, прямо в корпус. В общем, система несложная, но есть ряд спорных моментов.

Тёплый воздух выбрасывается через отверстие второго слота, но часть его попадает обратно в корпус через решётку на боковине GeForce 8800 GTX. Нажмите на картинку для увеличения.

Если в вашем компьютере PCIe-слоты находятся близко, и в SLI две платы встанут так, что зазор между ними будет не слишком велик, то температура в этом месте будет очень приличная. Нижняя карта будет дополнительно подогреваться верхней, через ту самую боковую решётку на системе охлаждения. Ну, а что случится, если установить три карты, лучше даже не думать. Получится отличный бытовой электронагреватель. В морозы будете работать около открытого окна.

Когда плата установлена в одиночку, система охлаждения впечатляет и отрабатывает на все сто. Как и у плат GeForce 7900 GTX, так и у она работает тихо. За весь шестичасовой тестовый прогон, при постоянной высокой нагрузке, плату не было слышно ни разу. Даже если полностью нагрузить плату работой, кулер на средних оборотах будет справляться с отводом тепла. Если вы поднесёте ухо к компьютеру сзади, то услышите лишь незначительный шум, своего рода тихое шуршание.

80-миллиметровый кулер работает тихо и никогда не включается на полную мощность. Система охлаждения платы занимает два слота. Нажмите на картинку для увеличения.

Специальный драйвер ForceWare 96.94, который nVidia приготовила для GeForce 8800 GTX, не выводит данные температурного мониторинга. До выхода этой версии вы могли выбрать между классическим и новым интерфейсом, но релиз 96.94 для прессы содержит только новую версию панели настроек . Если вы попытаетесь открыть настройки частот и температуры, драйвер отправит вас на сайт nVidia, чтобы вы могли скачать утилиту Ntune. Именно в ней и настраиваются эти функции. Скачиваем 30-мегабайтный архив и устанавливаем его. При первом запуске получаем полное зависание компьютера и Windows.

Если вы после установки Ntune выбираете регулировку частот и температуры в панели настроек, открывается специальная информационная страничка, где указаны настройки материнской платы. Никаких настроек , то есть информацию о частоте и температуре, вы найти не сможете. Поэтому мы проводили измерения температуры классическим способом - при помощи инфракрасного термометра. При полной загрузке измерения показали температуру 71 градус Цельсия, при работе в 2D-режиме карта удерживалась в рамках от 52 до 54 градусов.

Остаётся надеяться, что nVidia выпустит стандартную версию ForceWare для GeForce 8800. Классический интерфейс настройки иногда удобнее, к тому же, показывается информация о температуре, а при помощи coolbits можно регулировать частоты. Новый драйвер в паре с Ntune занимает порядка 100 мегабайт и сегментирован на немалое количество вкладок и окон. Работать с ним не всегда удобно.

В чипе GeForce 8800 GTX целых 681 миллион транзисторов, он производится по технологии 90 нанометров на фабрике TSMC. Нажмите на картинку для увеличения.

В чипе G80 GeForce 8800 GTX 681 миллион транзисторов. Это вдвое больше, чем в ядре Conroe процессоров Intel Core 2 Duo или в чипе GeForce 7. GPU видеокарты работает на частоте 575 МГц. Интерфейс памяти 384-битный и обслуживает 768 мегабайт. В качестве памяти nVidia использовала высокоскоростную GDDR3, которая работает на частоте 900 МГц.

Для сравнения: память GeForce 7900 GTX работает на частоте 800 МГц, а GeForce 7950 GT на 700 МГц. В видеокартах Radeon X1950 XTX используется память GDDR4 с частотой 1000 МГц. У карты GeForce 8800 GTS частота ядра составляет 500 МГц, объём памяти 640 Мбайт с частотой 800 МГц.

Результаты тестов показывают, что полноэкранное сглаживание и анизотропная фильтрация, наконец, никак при включении не снижают производительность. В ресурсоёмких играх, например, в Oblivion, раньше приходилось за этим следить, а теперь вы можете включать всё на максимум. Производительность предыдущих nVidia такова, что эти игры плавно шли только в разрешениях до 1024x768, при этом HDR-рендеринг с пиксельными шейдерами третьей версии отнимал огромное количество ресурсов. Видеокарты настолько мощны, что включение 4xAA и 8xAF без проблем позволяет играть в разрешениях до 1600x1200. Чип G80 поддерживает максимальные настройки сглаживания 16x и анизотропную фильтрацию 16x.

GeForce 8800 GTX поддерживает 16x сглаживание и анизотропную фильтрацию.

В сравнении с одиночными ATi у GeForce 8800 GTX нет конкурентов. Новинка nVidia теперь может вытянуть HDR-рендеринг с использованием третьих шейдеров и сглаживанием. HDR-рендеринг позволяет получить экстремальные отражения и блики, имитирует эффект ослепления, когда вы выходите из тёмного помещения на яркий свет. К сожалению, многие старые игры - Half Life Episode 1, Neef For Speed Most Wanted, Spellforce 2, Dark Messiah и другие - используют только вторые шейдеры для HDR-эффектов. Новые игры вроде Gothic 3 или Neverwinter Nights 2 используют предыдущий способ Bloom, как это было в Black & White 2. И хотя Neverwinter Nights 2 можно настроить для поддержки HDR-рендеринга, разработчик опасается этих функций, чтобы с нормальным FPS играть могли и те, у кого установлено обычное "железо". Правильно это реализовано в Oblivion, где есть и Bloom, и выдающиеся эффекты HDR-рендеринга через третьи шейдеры.

Поддерживает и четвёртые шейдеры (Shader Model 4.0), а самым важным нововведением является изменённая архитектура конвейера рендеринга. Она теперь не делится на пиксельные и вершинные шейдеры. Новое шейдерное ядро может обрабатывать все данные - вершинные, пиксельные, геометрические и даже физические. Это не навредило производительности - Oblivion работает почти вдвое быстрее, чем на оптимизированном под пиксельные шейдеры Radeon X1900 XTX или X1950 XTX.

Что поддерживает видеокарта в плане DirectX 10, пока невозможно протестировать. Windows Vista, Direct X 10 и игры под него ещё не существуют. Однако на бумаге всё выглядит более чем пристойно: геометрические шейдеры поддерживают карты смещения (Displacement Mapping), что позволит выводить ещё более реалистичные вещи, например, обсчитывать стереоскопические эффекты, объекты в форме желобов и гофрированные поверхности. Потоковый вывод (Stream Output) позволит получить ещё более качественные шейдерные эффекты для частиц и физики. Технология квантовых эффектов (Quantum Effect) хорошо справляется с просчётом эффектов дыма, тумана, огня и взрывов, и позволит снять их калькуляцию с центрального процессора. Всё это вместе даст значительно больше шейдерных и физических эффектов, которые можно будет увидеть в будущих играх. Как всё это будет реализовано на практике, в каких играх и в каком виде, покажет будущее.

GeForce 8800 GTX | Платы в тесте

| Видеокарты на nVidia | ||||||

| и чип | Кодовое название | Память | HDR-R | Верш./пикс. шейдеры | Частота GPU | Частота памяти |

| nVidia GeForce 8800 GTX | G80 | 768 Мбайт GDDR3 | Да | 4.0 | 575 МГц | 1800 МГц |

| Asus + Gigabyte GeForce 7900 GTX SLI | G71 | 512 Мбайт GDDR3 | Да | 3.0/3.0 | 650 МГц | 1600 МГц |

| Gigabyte GeForce 7900 GTX | G71 | 512 Мбайт | GDDR3 | Да | 3.0/3.0 | 650 МГц |

| nVidia GeForce 7950 GT | G71 | 512 Мбайт GDDR3 | Да | 3.0/3.0 | 550 МГц | 1400 МГц |

| Asus GeForce 7900 GT Top | G71 | 256 Мбайт GDDR3 | Да | 3.0/3.0 | 520 МГц | 1440 МГц |

| nVidia GeForce 7900 GS | G71 | 256 Мбайт GDDR3 | Да | 3.0/3.0 | 450 МГц | 1320 МГц |

| Asus GeForce 7800 GTX EX | G70 | 256 Мбайт GDDR3 | Да | 3.0/3.0 | 430 МГц | 1200 МГц |

| Gigabyte GeForce 7800 GT | G70 | 256 Мбайт GDDR3 | Да | 3.0/3.0 | 400 МГц | 1000 МГц |

| Asus GeForce 7600 GT | G73 | 256 Мбайт GDDR3 | Да | 3.0/3.0 | 560 МГц | 1400 МГц |

| nVidia GeForce 6800 GT | NV45 | 256 Мбайт GDDR3 | Да | 3.0/3.0 | 350 МГц | 1000 МГц |

| Gainward GeForce 7800 GS+ GSa AGP | G71 | 512 Мбайт GDDR3 | Да | 3.0/3.0 | 450 МГц | 1250 МГц |

В следующей таблице представлены ATi, принимавшие участие в нашем тестировании.

| Видеокарты на ATi | ||||||

| Видеокарта и чип | Кодовое название | Память | HDR-R | Верш./пикс. шейдеры | Частота GPU | Частота памяти |

| Club 3D + Club 3D Radeon X1950 XTX CF | R580+ | 512 Мбайт GDDR4 | Да | 3.0/3.0 | 648 МГц | 1998 МГц |

| Club 3D Radeon X1950 XTX | R580+ | 512 Мбайт GDDR4 | Да | 3.0/3.0 | 648 МГц | 1998 МГц |

| HIS + HIS Radeon X1900 XTX CF | R580 | 512 Мбайт GDDR3 | Да | 3.0/3.0 | 621 МГц | 1440 МГц |

| Gigabyte Radeon X1900 XTX | R580 | 512 Мбайт GDDR3 | Да | 3.0/3.0 | 648 МГц | 1548 МГц |

| Power Color Radeon X1900 XT | R580 | 512 Мбайт GDDR3 | Да | 3.0/3.0 | 621 МГц | 1440 МГц |

| ATI Radeon X1900 XT | R580 | 256 Мбайт GDDR3 | Да | 3.0/3.0 | 621 МГц | 1440 МГц |

| Sapphire Radeon X1900 GT | R580 | 256 Мбайт GDDR3 | Да | 3.0/3.0 | 574 МГц | 1188 МГц |

| HIS Radeon X1650 Pro Turbo | RV535 | 256 Мбайт GDDR3 | Да | 3.0/3.0 | 621 МГц | 1386 МГц |

| Gecube Radeon X1300 XT | RV530 | 256 Мбайт GDDR3 | Да | 3.0/3.0 | 560 МГц | 1386 МГц |

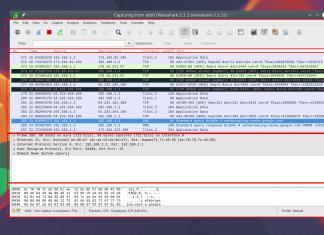

GeForce 8800 GTX | Тестовая конфигурация

Для тестирования мы использовали три эталонных стенда. Все они были основаны на предельно идентичных компонентах - двуядерном процессоре AMD Athlon 64 FX-60 с частотой 2,61 ГГц, комплектовались 2 гигабайтами ОЗУ Mushkin MB HP 3200 2-3-2, двумя жёсткими дисками Hitachi по 120 Гбайт в конфигурации RAID 0. Отличие заключалось в использованных материнских платах - для тестов одиночных и плат nVidia в режиме SLI мы использовали материнскую плату Asus A8N32-SLI Deluxe. Чтобы тестировать видеокарты в режиме CrossFire (это обозначено аббревиатурой CF

ниже на графиках), мы использовали такой же компьютер с эталонной материнской платой ATi на чипсете RD580. Наконец, AGP-видеокарты тестировались на компьютере в той же конфигурации, но на материнской плате ASUS AV8 Deluxe. Данные по конфигурации сведены в таблицу.

| Для всех видеокарт nVidia (включая SLI) и одиночных карт Ati | |

| Процессор | |

| Частота шины | 200 МГц |

| Материнская плата | Asus A8N32-SLI Deluxe |

| Чипсет | nVidia nForce4 |

| Память | |

| Жёсткий диск | Hitachi 2 x 120 Гбайт SATA, кэш 8 Мбайт |

| DVD | Gigabyte GO-D1600C |

| LAN-контроллер | Marvell |

| Звуковой контроллер | Realtek AC97 |

| Блок питания | Silverstone SST-ST56ZF 560 Вт |

| Для тестов видеокарт ATi в режиме CrossFire | |

| Процессор | Двуядерный AMD Athlon 64 FX-60 2.61 ГГц |

| Частота шины | 200 МГц |

| Материнская плата | Эталонная ATi |

| Чипсет | ATI RD580 |

| Память | Mushkin 2x1024 MB HP 3200 2-3-2 |

| LAN-контроллер | Marvell |

| Звуковой контроллер | AC97 |

| Для тестов AGP-видеокарт | |

| Процессор | Двуядерный AMD Athlon 64 FX-60 2.61 ГГц |

| Частота шины | 200 МГц |

| Материнская плата | Asus AV8 Deluxe |

| Чипсет | VIA K8T800 Pro |

| Память | Mushkin 2x1024 MB HP 3200 2-3-2 |

| LAN-контроллер | Marvell |

| Звуковой контроллер | Realtek AC97 |

На компьютерах для тестов одиночных видеокарт и плат nVidia в режиме SLI мы использовали Windows XP Professional с SP1a. Платы CrossFire и AGP-видеокарты тестировались на системах с установленной Windows XP Professional SP2. Версии драйверов и ПО сведены в следующую таблицу.

| Драйверы и конфигурация | |

| Видеокарты ATi | ATI Catalyst 6.6, X1900 XTX, X1950 + Crossfire, X1650 + Crossfire, X1300 XT + Crossfire, Crossfire X1900, Crossfire X1600 XT ATI Catalyst 6.7 (entspricht Catalyst 6.8), Crossfire X1600 Pro, Crossfire X1300 Pro, Crossfire X1300 ATI Catalyst 6.8 |

| Видеокарты nVidia | nVidia Forceware 91.31, 7900 GS, nVidia Forceware 91.47, 7950 GT nVidia Forceware 91.47 (Special), 8800 GTX nVidia Forceware 96.94 (Special) |

| Операционная система | Одиночные карты и SLI: Windows XP Pro SP1a, ATI Crossfire и AGP-видеокарты Windows XP Pro SP2 |

| Версия DirectX | 9.0c |

| Драйвер чипсета | nVidia Nforce4 6.86, AGP VIA Hyperion Pro V509A |

GeForce 8800 GTX | Результаты тестов

Эталонную плату мы в редакцию THG получили прямо из nVidia. Для тестирования нам предоставили специальный драйвер ForceWare 96.94, подготовленный эксклюзивно для прессы. - это карта с поддержкой DirectX 10 и Shader Model 4.0. Производительность в приложениях для DirectX 9 и Pixelshader 2 или Pixelshader 3 ошеломляет.

Включение сглаживания и анизотропной фильтрации почти не снижает производительность. В Half-Life 2 Episode 1 видеокарту GeForce 8800 GTX затормозить невозможно. В разрешении 1600x1200 чип на 60 процентов быстрее, чем Radeon X1950 XTX, в Oblivion производительность вдвое выше, чем у Radeon X1900 XTX или X1950 XTX. В игре Prey видеокарта в разрешении 1600x1200 на целых 55 процентов быстрее, чем Radeon X1950 XTX. В Titan Quest количество кадров в секунду не меняется, какое разрешение вы бы ни устанавливали, и составляет 55 FPS.

В тестах Half-Life 2: Episode 1 с HDR-рендерингом результаты платы впечатляют, но в низких разрешениях проигрывает Radeon X1950 XTX и платам в режиме CrossFire, находясь примерно на одном уровне с SLI-решениями на GeForce 7900 GTX. Отметим, что в низком разрешении лимитирующим фактором является не видеокарта. Чем выше мы задираем настройки, тем интереснее результат.

С включением сглаживания и анизотропной фильтрации картина начинает меняться. Все платы при этом немного теряют в производительности, но GeForce 8800 GTX падает при этом очень незначительно - всего на 10 fps в среднем, в то время как сдвоенная ATi Radeon X1950 XTX в режиме CrossFire теряет целых 20 fps.

Как только мы перешагиваем за разрешение 1280x1024 с включёнными сглаживанием и анизотропной фильтрацией, одиночная плата GeForce 8800 GTX выходит в несомненные лидеры. Показатели превышают таковые у Radeon X1950 XTX почти на 35 fps. Это существенная разница.

Дальше - больше. В 1600x1200 со сглаживанием и анизотропной фильтрацией отрыв от всех остальных плат становится кошмарным. В два раза от GeForce 7900 GTX SLI и чуть меньше от CrossFire Radeon X1950 XTX. Вот это дааа!

Наконец посмотрим на динамику снижения FPS с ростом разрешения и качества картинки. Мы видим, что у GeForce 8800 GTX снижение производительности незначительное - от голых 1024x768 до сглаженных и отфильтрованных методом анизотропии 1600x1200 разница составляет всего чуть больше 20 fps. Прежде топовые решения ATi и nVidia уходят далеко назад.

Игра Hard Truck: Apocalypse требовательна и к видеокарте, и к центральному процессору. Этим объясняются фактически одинаковые показатели в 1024x768, когда используется простая трилинейная фильтрация и выключено полноэкранное сглаживание.

Как только вы переходите на 4xAA и анизотропную фильтрацию 8x результаты начинают разниться. "Младшие" карты существенно теряют производительность, а как будто не замечает улучшения качества картинки.

В 1280x960 разница ещё более увеличивается, но GeForce 8800 GTX демонстрирует прежние показатели. Явно видно, что Athlon 64 FX-60 не способна поставить эту видеокарту на колени.

В 1600x1200 у всех одиночных плат показатели начинают стремиться к неиграбельным. Но GeForce 8800 GTX как показывала 51 fps, так и показывает.

Рассмотрим снижение производительности с ростом настроек. CrossFire Radeon X1950 XTX и GeForce 7900 GTX держатся рядом с , а карты старого поколения уже давно стоят на коленях и молят о пощаде.

В Oblivion, игре, которая нагружает видеокарту до предела, картина изначально удручающа для всех плат, кроме Radeon X1950 XTX в режиме CrossFire и . Мы собрали статистику и по работе видеокарт на открытых локациях, и при рендеринге закрытых помещений. Видно, что на свежем воздухе GeForce 8800 GTX стоит рядом или незначительно отстаёт от сдвоенной Radeon X1950 XTX.

Но когда разрешение доходит до 1600x1200, наша GeForce 8800 GTX уходит далеко вперёд. Особенно разрыв виден на закрытых уровнях.

Посмотрите на снижение производительности с ростом разрешения и качества. Картина не нуждается в комментариях. В закрытых локациях скорость непоколебима.

В игре Prey видеокарта находится между одноплатными решениями ATi Radeon X1950 XTX и этими же платами в режиме CrossFire. И чем выше разрешение, тем лучше выглядит GeForce 8800 GTX.

Сравнивать GeForce 8800 GTX с одноплатными решениями ATi и nVidia бесполезно. Разрыв в высоких разрешениях колоссален, да и в 1024x768 со сглаживанием он впечатляет.

В игре Rise of Nations: Rise of Legends видеокарта является единственным лидером. Если высчитывать разрыв между CrossFire Radeon X1950 XTX и GeForce 8800 GTX в процентах, то отрыв будет очень и очень велик. Если считать в fps, то разница не столь заметна, но всё же существенна.

Обратите внимание, как снижается скорость с ростом разрешения. При всех настройках GeForce 8800 GTX является лидером не только по сравнению с одиночными платами, но и с решениями SLI/CrossFire.

В игре Titan Quest карты nVidia показывают себя с лучшей стороны. При этом у от 1024x768 до 1600x1200 со сглаживанием и анизотропной фильтрацией fps не меняется.

Картину происходящего хорошо иллюстрирует следующий график. Производительность GeForce 8800 GTX находится на одном и том же уровне, вне зависимости от настроек.

В 3DMark06 карта отлично показывает себя и со вторыми, и с третьими шейдерами. Обратите внимание, насколько незначительно снижается производительность при включении анизотропии и сглаживания.

Рост разрешения тоже не пугает. Карта стоит на одном уровне с решениями SLI и CrossFire, значительно опережая всех предыдущих лидеров в одиночном забеге.

Чтобы вы лучше могли себе представить производительность в играх, мы перекомпоновали графики. Здесь нет сравнения, только чистый результат одной видеокарты. Стоит обратить внимание на то, что от разрешения к разрешению производительность GeForce 8800 GTX не меняется. Во всех играх ограничивающим фактором является недостаточно быстрый процессор AMD Athlon 64 FX-60. В будущем, с выходом гораздо более быстрых чипов, карта покажет себя ещё лучше в тех же самых играх. Думаем, и Core 2 Quad последнего поколения не способен заставить GeForce 8800 GTX достичь своего лимита.

Итак, покончив с результатами тестирования, давайте попытаемся составить рейтинг эффективности видеокарт. Для этого мы соберём воедино результаты всех игровых тестов и сопоставим их с ценой решения. За основу возьмём рекомендованные цены, то есть без наценок конкретных магазинов. Конечно, поначалу будут очень дорогими, и многие магазины заложат в цену избыточную прибыль. Но затем цены снизятся, и наверняка довольно скоро вы сможете приобрести GeForce 8800 GTX за более разумные деньги.

Как мы видим, по производительности GeForce 8800 GTX обходит практически все решения, включая сдвоенные CrossFire и SLI. В абсолютных показателях GeForce 8800 GTX очень быстра. Но как насчёт цены?

Цена у соответствующая - производитель просит за плату 635 евро. Это много, но ведь за две платы Radeon X1900 XTX в режиме CrossFire вам придётся заплатить больше - 700 евро. А за две Radeon X1950 XTX или SLI GeForce 7900 GTX целых 750 евро. При том, что в некоторых тестах одиночная GeForce 8800 GTX обходит эти решения, да и в корпусе занимает меньше места по ширине, есть о чём подумать.

Наконец разделим fps на деньги. Мы видим, что у этот показатель лучше, чем у SLI и CrossFire. Конечно, стоимость каждого fps будет выше, чем у GeForce 7800 GTX EX, и, конечно, заметно выше, чем у Radeon X1300 XT. Но и производительность платы соответствующая. Очень эффективное решение в ключе соотношения цены и производительности.

Мы решили дополнить наш обзор результатами тестов американской лаборатории THG, где также участвовала карта GeForce 8800 GTS. Обратите внимание, что из-за различий в тестовой конфигурации не следует напрямую сравнивать результаты, приведённые выше, с результатами американской лаборатории.

Карта GeForce 8800GTX длиннее, чем Radeon X1950XTX и большинство других карт на рынке. 8800GTS несколько короче.

Как и другие тесты графических видеокарт в 2006 году, мы проводили тестирование на платформе AMD Athlon FX-60. Также мы приведём результаты конфигураций с несколькими GPU. Кроме того, оценим, как ведут себя новые видеокарты, когда производительность упирается в CPU (низкое разрешение и качество картинки).

| Системное аппаратное обеспечение | |

| Процессоры | AMD Athlon 64 FX-60, 2,6 ГГц, 1,0 ГГц HTT, кэш L2 1 Мбайт |

| Платформа | nVidia: Asus AN832-SLI Premium, nVidia nForce4 SLI, BIOS 1205 |

| Память | Corsair CMX1024-4400Pro, 2x 1024 Мбайт DDR400 (CL3,0-4-4-8) |

| Жёсткий диск | Western Digital Raptor, WD1500ADFD, 150 Гбайт, 10 000 об/мин, кэш 16 Мбайт, SATA150 |

| Сеть | Встроенная nForce4 Gigabit Ethernet |

| Видеокарты | ATi Radeon X1950XTX 512 Мбайт GDDR4, 650 МГц ядро, 1000 МГц память (2,00 ГГц DDR) Карты nVidia: nVidia GeForce 8800GTX 768 Мбайт GDDR3, 575 МГц ядро, 1,350 ГГц потоковые процессоры, 900 МГц память (1,80 ГГц DDR) XFX GeForce 8800GTS 640 Мбайт GDDR3, 500 МГц ядро, 1,200 ГГц потоковые процессоры, 800 МГц память (1,60 ГГц DDR) nVidia GeForce 7900GTX 512 Мбайт GDDR3, 675 МГц ядро, 820 МГц память (1,64 ГГц DDR) |

| Блок питания | PC Power & Cooling Turbo-Cool 1000 Вт |

| Кулер CPU | Zalman CNPS9700 LED |

| Системное ПО и драйверы | |

| ОС | Microsoft Windows XP Professional 5.10.2600, Service Pack 2 |

| Версия DirectX | 9.0c (4.09.0000.0904) |

| Графические драйверы | ATi - Catalyst 6.10 WHQL nVidia - ForceWare 96.94 Beta |

Во время первого прогона 3DMark мы проводили тесты на всех разрешениях, но с выключенными полноэкранным сглаживанием и анизотропной фильтрацией. Во втором прогоне мы включили опции улучшения картинки 4xAA и 8xAF.

nVidia в 3DMark05 явно находится на первом месте. GeForce 8800 GTX даёт такой же результат в разрешении 2048x1536, что ATi Radeon X1950 XTX в разрешении по умолчанию 1024x768. Впечатляет.

В Doom 3 обычно доминируют карты nVidia, поскольку их дизайн хорошо подходит для этой игры. Но ATi не так давно смогла "взять" эту игру с новыми картами.

Здесь мы впервые сталкиваемся с ограничениями вычислительной мощности CPU, поскольку при низком разрешении результат составляет где-то 126 кадров в секунду. Карта ATi способна дать более высокое число кадров в секунду на данной системной конфигурации. Причина кроется в драйверах. Дело в том, что ATi выпускает драйверы, которые меньше нагружают CPU. В результате CPU находится в более выгодных условиях и может дать больше производительности для графической подсистемы.

В целом же, победителем становятся новые карты 8800. Если посмотреть на результаты при всех разрешениях, новые карты DX10 обходят Radeon X1950 XTX, начиная от 1280x1024 и выше.

GeForce 8800 GTX и GTS | F.E.A.R.

В F.E.A.R. обычно лидируют карты nVidia. Но, опять же, здесь заметна меньшая нагрузка на CPU у драйверов ATi. Конечно, с более скоростной платформой результаты будут иными, но если ваш компьютер не является передовым, то данный тест наглядно показывает, как карты G80 будут на нём работать. Но если не считать теста в разрешении 1024x768, G80 просто убивает Radeon X1950 XTX. GTX - это монстр. И не важно, какую нагрузку мы даём на GeForce 8800 GTX, карта всегда обеспечивает более 40 кадров в секунду.

Нажмите на картинку для увеличения.

Второй скриншот (ниже) взят на 8800 GTX с теми же настройками.

|

Нажмите на картинку для увеличения.

Картинка nVidia по качеству намного превосходит скриншот ATi. Похоже, в этом отношении nVidia вновь вышла в лидеры. Перед нами ещё одно преимущество, которым обладают карты nVidia на чипе G80.

Перед вами таблица новых возможностей улучшения качества на картах G80.

Кроме новых видеокарт DX10, nVidia также показала несколько функций, которые будут доступны на картах G80. И первая из них - патентованная технология улучшения качества картинки под названием Coverage Sampled Antialiasing (CSAA).

Новая версия полноэкранного сглаживания использует область из 16 субсэмплов. По информации nVidia, в результате можно сжать "избыточную информацию о цветах и глубине в область памяти и пропускную способность четырёх или восьми мультисэмплов". Новый уровень качества работает более эффективно, снижая объём данных на сэмпл. Если CSAA не заработает с какой-либо игрой, то драйвер вернётся к традиционным методам сглаживания.

Нажмите на картинку для увеличения.

Перед тем, как мы закончим этот обзор, позвольте поговорить ещё о двух аспектах видеокарт, которые уже давно разрабатываются и со временем станут более важными. Первый аспект - воспроизведение видео. Во время правления GeForce 7 по качеству воспроизведения видео лидировали карты ATi Radeon X1900. Но ситуация изменилась с появлением унифицированных шейдеров с выделенным ядром Pure Video.

Благодаря умным алгоритмам и 128 вычислительным блокам, GeForce 8800 GTX смогла получить 128 из 130 баллов в HQV. В ближайшем будущем мы планируем выпустить более подробную статью, касающуюся качества картинки, так что следите за новостями на нашем сайте.

Наконец, очень сильной стороной G80 является то, что nVidia называет CUDA. Многие годы учёные и энтузиасты ищут способы, чтобы выжать больше производительности из мощных параллельных процессоров. Кластер Beowulf, конечно, не всем по карману. Поэтому обычные смертные предлагают разные способы, как можно использовать для вычислений видеокарту.

Проблема здесь следующая: графический процессор хорош для параллельных вычислений, но вот с ветвлениями он справляется плохо. Здесь как раз хорошо подходит CPU. Кроме того, если вы хотите использовать видеокарту, то следует программировать шейдеры, как это делают игровые разработчики. nVidia вновь решила выйти вперёд, представив архитектуру Compute Unified Device Architecture или CUDA.

Так может работать CUDA для симуляции жидкости.

nVidia выпустила компилятор C+, получающиеся программы которого могут масштабироваться под вычислительные мощности GPU (например, 96 потоковых процессоров в 8800 GTS или 128 в 8800 GTX). Теперь программисты получили возможность создавать программы, которые масштабируются по ресурсам как CPU, так и GPU. CUDA наверняка понравится разным программам распределённых вычислений. Впрочем, CUDA может использоваться не только для просчёта блоков, но и для симуляции других эффектов: объёмной жидкости, одежды и волос. Через CUDA на GPU можно потенциально перенести расчёты физики и даже других игровых аспектов.

Разработчикам будет представлен полный набор SDK.

GeForce 8800 GTX и GTS | Заключение

Те, кто сейчас перейдёт с GeForce 6 на , получат почти трёхкратное увеличение производительности. Неважно, когда выйдут игры для DirectX 10, не так важно, что нам дадут четвёртые шейдеры - уже сегодня GeForce 8800 GTX это самый быстрый чип. Такие игры, как Oblivion, Gothic 3 или Dark Messiah, будто ждали выхода чипа G80 и видеокарт . Играть без тормозов стало опять возможным. У GeForce 8800 GTX достаточно мощности для всех самых современных игр.

Система охлаждения работает тихо, 80-миллиметровый кулер на эталонной карте было не услышать. Даже при полной нагрузке скорость вращения кулера невысока. Интересно, чем на это ответит компания ATi. В любом случае, nVidia проделала чертовски хорошую работу и выпустила действительно мощную "железку".

Недостатки : длина платы 27 сантиметров, она занимает место двух слотов PCI Express. Блок питания должен быть, как минимум, на 450 ватт (12 В, 30 А). Для GeForce 8800 GTS минимумом станет БП на 400 ватт с 30 амперами по шине 12 вольт.

Следуя давним традициям, карты nVidia уже доступны в онлайновых магазинах. На международном рынке рекомендованная цена GeForce 8800GTX составляет $599, а GeForce 8800GTS - $449. Да и игры под DX10 должны вскоре появиться. Но что не менее важно, вы получите более качественную картинку уже в существующих играх.

|

Вот так может выглядеть супермодель, выведенная с помощью DX10. Нажмите на картинку для увеличения.

GeForce 8800 GTX и GTS | Мнение редактора

Лично я впечатлён реализацией DX10/D3D10 от nVidia. Просмотр Crysis в реальном времени и многочисленных демонстраций впечатляет. Реализация CUDA позволяет превратить видеокарту в нечто большее, чем просто устройство рендеринга кадров. Теперь программы смогут использовать не только ресурсы CPU, но и всю параллельную мощь универсального шейдерного ядра GPU. Не терпится посмотреть на подобные решения в реальности.

Но G80 оставляет желать лучшего. Чего же? Конечно, новых игр. Господа разработчики, будьте так добры, поскорее выпустите игры DX10.

GeForce 8800 GTX | Фотогалерея

Подобным образом компания NVIDIA поступила и с новейшим чипом G80, первым в мире графическим процессором, являющимся носителем унифицированной архитектуры и обладающим поддержкой нового API от Microsoft – DirectX 10.

Одновременно с флагманской видеокартой GeForce 8800 GTX вышла и более дешевая версия, именуемая GeForce 8800 GTS. От старшей сестры её отличает урезанное количество пиксельных процессоров (96 против 128), видеопамяти (640 МБ вместо 768 МБ у GTX). Следствием уменьшения количества чипов памяти стало уменьшение разрядности ее интерфейса до 320 бит (у GTX - 384 бит). С более детальными характеристиками рассматриваемого графического адаптера можно ознакомиться, изучив таблицу:

В нашу Тестовую лабораторию попала видеокарта ASUS EN8800GTS, которую мы сегодня и рассмотрим. Данный производитель является одним из крупнейших и наиболее успешных партнеров NVIDIA, и традиционно не скупится на оформление упаковки и комплектацию. Как говорится, «хорошей видеокарты должно быть много». Новинка поставляется в коробке внушительных размеров:

На лицевой ее стороне красуется персонаж из игры Ghost Recon: Advanced Warfighter. Одним изображением дело не ограничивается, - сама игра, как Вы уже догадались, идет в комплекте. На обратной стороне упаковки приведены краткие характеристики продукта:

В ASUS посчитали это количество информации недостаточным, сделав из коробки некое подобие книги:

Справедливости ради отметим, что этот метод практикуется уже довольно давно и, отнюдь, не только ASUS. Но, как говориться, всё хорошо в меру. Максимальная информативность обернулась практическим неудобством. Небольшое дуновение ветра - и верхняя часть обложки открывается. При транспортировке героя сегодняшнего обзора нам пришлось ухищряться и подгибать удерживающий язычок так, что бы он оправдывал своё предназначение. К сожалению, подогнув его, легко повредить упаковку. Ну и напоследок добавим, что размеры коробки неоправданно велики, что вызывает некоторые неудобства.

Видеоадаптер: комплектация и близкий осмотр

Что же, перейдем непосредственно к комплектации и самой видеокарте. Адаптер упакован в антистатический пакет и пенопластовую емкость, что исключает как электрическое, так и механическое повреждение платы. В коробке находятся диски, переходники «DVI -> D-Sub», шнуры VIVO и дополнительного питания, а так же футляр для дисков.

Из дисков, входящих в комплект, примечательна игра GTI racing и бенчмарк 3DMark06 Advanced Edition! Первый раз в комплекте серийной и причем массовой видеокарты замечен 3DMark06! Без сомнения, этот факт придется по вкусу пользователям, активно занимающимся бенчмаркингом.

Что же, переходим непосредственно к видеокарте. Она выполнена на базе печатной платы эталонного дизайна с применением референсной системы охлаждения, и от других подобных продуктов её отличает лишь наклейка с логотипом производителя, на которой сохраняется тематика Ghost Recon.

Обратная сторона печатной платы также ничем не примечательна – на ней распаяно множество smd-компонентов и регуляторы стабилизаторов напряжений, только и всего:

В отличие от GeForce 8800 GTX, для GTS требуется лишь один разъем дополнительного питания:

Помимо этого, она короче старшей сестры, что наверняка придется по вкусу обладателям небольших корпусов. В плане охлаждения отличий нет, и ASUS EN8800GTS, как и GF 8800 GTX, использует кулер с большим вентилятором турбинного типа. Радиатор выполнен из медного основания и алюминиевого кожуха. Теплопередача от основания к ребрам осуществляется отчасти по тепловым трубкам, что увеличивает общую эффективность конструкции. Горячий воздух выбрасывается за пределы системного блока, однако часть его, увы, остается внутри ПК благодаря некоторым отверстиям в кожухе системы охлаждения.

Впрочем, проблема сильного нагреве легко решается. Например, весьма неплохо улучшает температурный режим платы обдув тихоходным 120-миллиметровым вентилятором.

Помимо графического процессора, кулер охлаждает чипы памяти и элементы подсистемы питания, а так же ЦАП видеосигнала (чип NVIO).

Последний был вынесен за пределы основного процессора по причине высоких частот последнего, что вызывало наводки и, как следствие, помехи в работе.

К сожалению, это обстоятельство вызовет трудности при смене кулера, поэтому инженеры NVIDIA просто не имели права сделать его некачественным. Посмотрим на видеокарту в «голом» виде.

На PCB распаяны чип G80 ревизии A2, 640 МБ видеопамяти, набранной десятью чипами производства Samsung. Время выборки памяти составляет 1,2 нс, что немного выше, чем у GeForce 8800 GTX.

Обратите внимание, на плате есть два посадочных места под чипы. Будь они распаяны на PCB, суммарный объем памяти составил бы 768 МБ, а ее разрядность - 384 бит. Увы, разработчик видеокарты посчитал подобный шаг лишним. Такая схема применяется только в профессиональных видеокартах серии Quadro.

Напоследок отметим, что у карты только один разъем SLI, в отличие от GF 8800 GTX, у которой их два.

Тестирование, анализ результатов

Испытания видеокарты ASUS EN8800GTS проходили на тестовом стенде следующей конфигурации:- процессор - AMD Athlon 64 3200+@2400МГц (Venice);

- материнская плата - ASUS A8N-SLI Deluxe, чипсет NVIDIA nForce 4 SLI;

- оперативная память - 2х512Мб DDR400@240МГц, тайминги 3.0-4-4-9-1T.

Утилита RivaTuner подтвердила соответствие характеристик видеокарты заявленным:

Частоты видеопроцессора составляют 510/1190 МГц, памяти - 1600 МГц. Максимальный нагрев, достигнутый после многократного прогона теста Canyon Flight из пакета 3DMark06, составил 76 °С при скорости вращения вентилятора штатной системы охлаждения, равной 1360 об/мин:

Для сравнения скажу, что в тех же условиях попавшая под руку GeForce 6800 Ultra AGP нагревалась до 85 °C при максимальной скорости вентилятора, а после длительной работы вообще зависала.

Производительность нового видеоадаптера проверялась с помощью популярных синтетических бенчмарков и некоторых игровых приложений.

Тестирование приложениями разработки Futuremark выявило следующее:

Конечно, на системе с более мощным центральным процессором, например, представителем архитектуры Intel Core 2 Duo, результат был бы лучше. В нашем случае морально устаревший Athlon 64 (пусть даже и разогнанный) не позволяет полностью раскрыть потенциал топовых видеокарт современности.

Перейдем к тестированию в реальных игровых приложениях.

В Need for Speed Carbon отчетливо видна разница между соперниками, и GeForce 7900 GTX отстает от карт поколения 8800 более чем ощутимо.

Поскольку для комфортной игры в Half Life 2 требуется не только мощная видеокарта, но и быстрый процессор, отчетливая разница в производительности наблюдается только в максимальных разрешениях с активированными анизотропной фильтрацией и полноэкранным сглаживанием.

В F.E.A.R. наблюдается примерно такая же картина, как и в HL2.

В тяжелых режимах игры Doom 3 рассматриваемая карта проявила себя очень неплохо, но сполна оценить отставание GeForce 8800 GTS от старшей сестры не позволяет все тот же слабый центральный процессор.

Поскольку Pray сделан на движке Quake 4, который в свою очередь является развитием Doom3, результаты производительности видеокарт в данных играх схожи.

Прогрессивность новой унифицированной шейдерной архитектуры и некоторое "урезание" возможностей относительно старшей сестры поставили GeForce 8800 GTS между самым быстрым графическим адаптером от NVIDIA на сегодня и флагманом семитысячной линейки. Впрочем, вряд ли калифорнийцы поступили бы иначе, - новинка такого класса должна быть мощнее предшественников. Радует, что GeForce 8800 GTS по скоростным возможностям находится гораздо ближе к GeForce 8800 GTХ, нежели к 7900 GTX. Оптимизм вселяет и поддержка самых новых графических технологий, которая должна оставить владельцам подобных адаптеров неплохой запас производительности на ближайшее (и, надеемся, более отдаленное) будущее.

Вердикт

После исследования карты у нас остались исключительно хорошие впечатления, которые намного улучшил фактор стоимости продукта. Так, в момент появления на рынке и некоторое время спустя ASUS EN8800GTS по данным price.ru стоила порядка 16000 руб, - ее цена была явно завышена. Теперь же карта длительный период продается примерно за 11500 руб, что не превышает стоимости аналогичных продуктов от конкурентов. Однако, учитывая комплектацию, детище ASUS, несомненно, находится в выигрышном положении.Плюсы :

- поддержка DirectX 10;

- усиленная структура чипа (унифицированная архитектура);

- отменный уровень производительности;

- богатая комплектация;

- именитый бренд;

- цена находится на уровне продуктов от менее авторитетных конкурентов

- не всегда удобная большая коробка

Отзывы, пожелания и замечания по данному материалу принимаются в форума сайт

.

9 ноября прошлого года Nvidia анонсировала первый потребительский графический процессор с унифицированной архитектурой и поддержкой DirectX 10. Новинка была подробно описана нами в обзоре Directly Unified: Nvidia GeForce 8800 Architecture Review. Изначально, новинка легла в основу двух новых графических карт – GeForce 8800 GTX и GeForce 8800 GTS. Как известно, старшая модель отлично показала себя в играх и вполне может считаться выбором энтузиаста, которого не смущает цена, младшая же модель заняла достойное место в своей ценовой категории – менее $500, но более $350.

$449 – не очень большая цена за продукт нового поколения, обладающий полноценной поддержкой DirectX 10 и могущий предложить пользователю серьезный уровень производительности в современных играх. Тем не менее, Nvidia решила не останавливаться на достигнутом, и 12 февраля 2007 года представила на суд публики более доступную модель GeForce 8800 GTS 320MB с официальной стоимостью $299, чем серьезно укрепила свои позиции в этом секторе. Об этих двух графических картах и пойдет речь в сегодняшнем обзоре. Попутно мы выясним, насколько критичен для семейства GeForce 8 объем видеопамяти.

GeForce 8800 GTS: технические характеристики

Для оценки качеств и возможностей обеих моделей GeForce 8800 GTS нам следует напомнить нашим читателям характеристики семейства GeForce 8800.Все три модели GeForce 8800 используют одно и то же графическое ядро G80, состоящее из 681 миллиона транзисторов, а также дополнительный чип NVIO, содержащий в своем составе TMDS-трансмиттеры, RAMDAC и т.п.. Использование столь сложного чипа для производства нескольких моделей графических адаптеров, относящихся к разным ценовым категориям, не является самым лучшим вариантом с точки зрения себестоимости конечного продукта, однако и неудачным его не назовешь: у Nvidia появляется возможность продать отбракованные версии GeForce 8800 GTX (не прошедшие отбраковку по частотам и/или имеющих некоторое количество дефектных блоков), а себестоимость видеокарт, продающихся по цене свыше $250 едва ли критична. Данный подход активно используется как Nvidia, так и её заклятым конкурентом – ATI, достаточно вспомнить историю графического процессора G71, который можно найти как в массовом недорогом видеоадаптере GeForce 7900 GS, так и в мощном двухчиповом монстре GeForce 7950 GX2.

Таким же образом был создан и GeForce 8800 GTS. Как можно увидеть из таблицы, в плане технических характеристик этот видеоадаптер значительно отличается от старшего собрата: у него не только ниже тактовые частоты и отключена часть потоковых процессоров, но также сокращен объем видеопамяти, урезана ширина шины доступа к ней и неактивна часть TMU и блоков растеризации.

Всего GeForce 8800 GTS располагает 6 группами потоковых процессоров, по 16 ALU в каждой, что дает в сумме 96 ALU. Главный соперник этой карты, AMD Radeon X1950 XTX, несет в своем составе 48 пиксельных процессоров, каждый из которых, в свою очередь, состоит из 2 векторных и 2 скалярных ALU – в сумме 192 ALU.

Казалось бы, в чистой вычислительной мощности GeForce 8800 GTS должен достаточно серьезно уступать Radeon X1950 XTX, но существует ряд нюансов, делающих такое предположение не вполне правомерным. Первый из них заключается в том, что потоковые процессоры GeForce 8800 GTS, подобно ALU в Intel NetBurst, работают на значительно более высокой частоте, нежели остальные части ядра – 1200 МГц против 500 МГц, что уже означает весьма серьезную прибавку к производительности. Другой нюанс следует из особенностей архитектуры графического процессора R580. Теоретически, каждый из его 48 блоков исполнения пиксельных шейдеров способен выполнять 4 инструкции за такт, не считая инструкции ветвления. Однако только 2 из них будут иметь тип ADD/MUL/MADD, а две оставшиеся всегда представляют собой инструкции ADD с модификатором. Соответственно, эффективность пиксельных процессоров R580 будет максимальной не во всех случаях. С другой стороны, потоковые процессоры G80 имеют полностью скалярную архитектуру и каждый из них способен исполнять за такт две скалярные операции, например, MAD+MUL. Хотя точных данных об архитектуре потоковых процессоров Nvidia мы по-прежнему не имеем, в данной статье мы рассмотрим, насколько новая унифицированная архитектура GeForce 8800 прогрессивней архитектуры Radeon X1900 и как это отражается на скорости в играх.

Что касается производительности систем текстурирования и растеризации, то, судя по характеристикам, на стороне GeForce 8800 GTS большее количество текстурников (24) и растеризаторов (20) по сравнению с Radeon X1950 XTX (16 TMU, 16 ROP), однако, их тактовая частота (500МГц) ощутимо ниже тактовой частоты продукта ATI (650MHz). Таким образом, решающего преимущества не имеет ни одна из сторон, а значит, на производительность в играх повлияет в основном "удачность" микро-архитектуры, а не численное преимущество исполнительных блоков.

Примечательно, что как GeForce 8800 GTS, так и Radeon X1950 XTX имеют одинаковую пропускную способность памяти – 64ГБ/сек, однако GeForce 8800 GTS использует 320-битную шину доступа к видеопамяти, в ней используется память GDDR3, работающая на частоте 1600МГц, тогда как у Radeon X1950 XTX можно найти 2ГГц память GDDR4 с 256-битным доступом. С учетом деклараций ATI более совершенного контроллера памяти с кольцевой топологией у R580 по сравнению с типичным контроллером Nvidia, будет интересно посмотреть, получит ли решение ATI Radeon некоторое преимущество в высоких разрешениях при включенном полноэкранном сглаживании против конкурента нового поколения, как это случалось в случае с GeForce 7.

Менее дорогой вариант GeForce 8800 GTS c 320MB памяти, анонсированный 12 февраля 2007 года и призванный заменить GeForce 7950 GT в сегменте решений класса performance-mainstream, отличается от обычной модели только объемом видеопамяти. Фактически, для получения этой карты Nvidia понадобилось всего лишь заменить микросхемы памяти емкостью 512 Мбит на чипы емкостью 256 Мбит. Простое и технологичное решение, оно позволило утвердить Nvidia свое технологическое превосходство в достаточно популярной среди пользователей ценовой категории $299. В дальнейшем мы выясним, насколько это отразилось на производительности новинки и стоит ли потенциальному покупателю доплачивать $150 за модель с 640 МБ видеопамяти.

В нашем сегодняшнем обзоре GeForce 8800 GTS 640MB будет представлена видеоадаптером MSI NX8800GTS-T2D640E-HD-OC. Расскажем об этом продукте подробнее.

MSI NX8800GTS-T2D640E-HD-OC: упаковка и комплектация

Видеоадаптер прибыл в нашу лабораторию в розничном варианте – упакованный в красочную коробку вместе со всеми сопутствующими аксессуарами. Коробка оказалась сравнительно небольшой, особенно, в сравнении с коробкой от MSI NX6800 GT, которая в свое время могла поспорить по части габаритов с упаковками Asustek Computer. Несмотря на скромные размеры, упаковка MSI традиционно снабжена удобной ручкой для переноски.

Оформление коробки выполнено в спокойных бело-голубых тонах и не режет глаз; лицевую сторону украшает изображение симпатичной рыжеволосой девушки-ангела, так что об агрессивных мотивах, столь популярных среди производителей видеокарт, речи не идет. Три наклейки сообщают покупателю о том, что карта предварительно разогнана производителем, поддерживает HDCP и комплектуется полной версией игры Company of Heroes. На обратной стороне коробки можно найти информацию о технологиях Nvidia SLI и MSI D.O.T. Express. Последняя является технологией динамического разгона, и, по заявлению MSI, позволяет поднять производительность видеоадаптера на 2%-10%, в зависимости от используемого профиля разгона.

Открыв коробку, помимо самого видеоадаптера, мы обнаружили следующий набор аксессуаров:

Краткое руководство по установке

Краткое руководство пользователя

Переходник DVI-I -> D-Sub

Разветвитель YPbPr/S-Video/RCA

Кабель S-Video

Переходник питания 2хMolex -> 6-pin PCI Express

CD с драйверами и утилитами MSI

Двухдисковое издание игры Company of Heroes

Оба руководства выполнены в виде постеров; на наш взгляд, они слишком просты и содержат только самую базовую информацию. Погоня за количеством языков, а их в кратком руководстве пользователя 26, привело к тому, что ничего особенно полезного, кроме основных сведений по установке карты в систему, из него почерпнуть не удастся. Мы считаем, что руководства могли бы быть несколько поподробней, что дало бы некоторое преимущество неопытным пользователям.

Диск с драйверами содержит устаревшую версию Nvidia ForceWare 97.29, а также ряд фирменных утилит, среди которых отдельного упоминания заслуживают MSI DualCoreCenter и MSI Live Update 3. Первая представляет собой унифицированный центр управления, позволяющий осуществлять разгон как видеокарты, так и центрального процессора, однако, для полной функциональности программа требует наличия системной платы MSI, оснащенной чипом CoreCell и, следовательно, малополезна владельцам плат других производителей. Утилита MSI Live Update 3 предназначена для отслеживания обновлений драйверов и BIOS и удобного их обновления через Интернет. Это достаточно удобный способ, особенно для тех, кто не желает разбираться в тонкостях ручного процесса обновления BIOS видеоадаптера.

Наличие в комплекте полной версии популярной тактической RTS Company of Heroes заслуживает отдельной похвалы MSI. Это действительно игра высшей категории, с отличной графикой и досконально проработанным игровым процессом; многие игроки называют ее лучшей игрой в этом жанре, что подтверждается многочисленными наградами, в том числе – званием "Лучшая Стратегическая Игра E3 2006". Как мы уже отмечали, несмотря на принадлежность к жанру стратегий реального времени, Company of Heroes может похвастаться современной графикой на уровне неплохого шутера с видом от первого лица, поэтому игра отлично подходит для демонстрации возможностей GeForce 8800 GTS. Помимо Company of Heroes, на дисках можно найти демо-версию Warhammer 40.000: Dawn of War – Dark Crusade.

Комплектацию MSI NX8800GTS-T2D640E-HD-OC мы можем с уверенностью назвать хорошей благодаря наличию полной версии очень популярной тактической RTS Company of Heroes и удобному программному обеспечению от MSI.